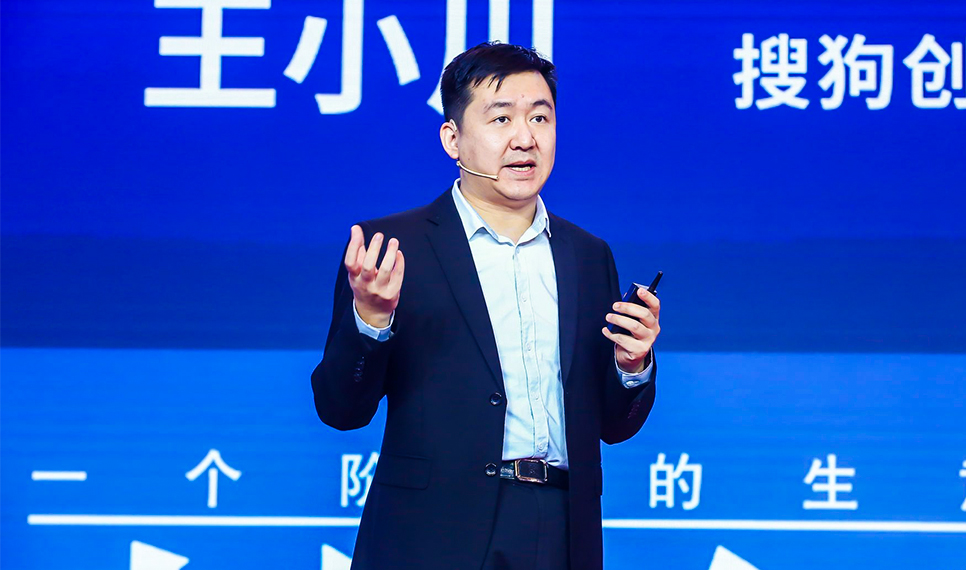

12月9日,2019年第十八届中国企业领袖年会于12月8日-9日在北京召开。搜狗创始人、CEO王小川与阿里巴巴产业互联网中心主任对话。

以下为演讲实录,经投资界(ID:pedaily2012)整理如下:

王小川:刚才主持人一讲我年岁不大,其实也不小了。耕耘互联网已经20多年了,从1999年chinaren到现在整整20年,见证也享受着互联网的发展。

今天我觉得我自己还是能够谈一些技术的,2016年AlphaGo出世时大家都觉得AI时代来了,怎么样?三年过去,大家觉得这个概念模糊了,AI今天主要是做TO B的事情,商业模式在C端并没有见到多少成功的案例。往下走10年时间来看,我会做一些预言,跟大家分享一下思考和积累。

今天我的题目叫“语言AI”,明年是2020,2020年是一个特别让人内心有冲动的日子,因为2000年的时候大家说2020就是代表未来的科技,我认为明年开始会有一轮新的爆发。

大家觉得之前讲的东西都太软了,能不能讲点硬货。开场我想先拿一个硬货开始。我们做输入法、搜索,也做了一些翻译等等的东西,这个事情是我们的一个硬货。在今年3月份我们开卖搜狗的AI录音笔,是我们第一款完整集成了AI能力的小硬件。这个硬件一卖之后,就成为“双11”多个主流平台的单品,我们预期明年几款上市之后很快成为这个领域当中,从销量到收入,到利润可能是排在第一的位置,这是用AI去颠覆了一个小小的行业。“颠覆”这个词有点大,但确实可以看到录音笔因此发生了变化。传统录音笔都是收音就行了,今天我们能够用双麦克风矩阵录音,做到听得清,而且中间还有降噪技术。把AI降噪放进去,最大的区别是你拿到录音笔之后直接可以转写成文字,直接做云端存储,直接被检索,生成文章的摘要,帮助你做编辑。不仅收音,而且对声音背后的意义做理解处理,甚至有同声传译的能力。笔开卖之后,不断有复购率,买一只之后买十只,买好多,这代表着产品取得了一定的小小的成功。

说一个很有意思的小数据,录音笔市场本身是一个下滑的市场,从2013年开始到现在一直走低,从400多万每年的销量,略微在走低。今年发生一个变化,今年3月份我们发布录音笔之后,整个在主流电商平台的录音笔的搜索量出现了一个反弹。大家觉得手机已经把录音笔慢慢取代了,但是从这个数据可以看到,因为AI的注入,会使得这样一个硬件开始发出新的活力,搜索量已经开始呈现了逐步上升的局面。我们可以预期,明年到后年这样一个产品随着AI点燃之后,能够又重新成为大家一个新的伴侣。不只是在工作场合用录音笔,录音笔增加一个功能,叫一键把声音上传区块链,防篡改、防删除,可以让每个消费者都用这样一个新的模式。以后大家用微信,可以不用手机了,我们搭了一个脉络,在行业中做一个创新联盟,这个联盟中间索尼、纽曼、爱国者这些主流的玩家都加入了。这是一个挺有意思的小现象。一个非录音笔、非硬件的公司能在这里面有所斩获甚至重新重组了这样一个联盟的生态。

我们怎么看AI和个人硬件的发展?看硬件的时候大家想到什么?音箱大家看的比较多。我个人在这张图里没有把它放进来,我认为那不是未来的产品形态,我预言在未来几年后这个产品就不性感了。

怎么看?我有两个大的法则。一件事情是AI硬件是从固定的设备开始走向移动化,从携带开始变成穿戴,越来越轻便,移动现实的硬件是一个走势。我们原来用PC机,每个人每天用PC机30到40分钟。随后有了笔记本、手机,到今天出现了手表、耳机。所以,整个智能硬件的走势更加便携化和穿戴化。

我认为未来几年眼镜会成为我们现在新的智能硬件的组成部分。

另外一件事情,除了便携还有一个大的脉络,就是更加IO导向,以前计算机是内存导向,但是随着新的硬件开始出生,笔记本到手机开始,开始有了声音,有了麦克风,有了更好的各种传感器、GPS,移动传感器到后面磁力计、心率监控,能够从环境当中捕获更多的数据,甚至是这种数据来自于人身体的感官,使得机器开始通过IO逐步从人适应机器走向机器适应人,开始接管人的感官。这是另外一个趋势。

基于这两个趋势,我对音箱略有持有所保留意见,既不够移动,也不够IO。

这是我认为未来的一个主线。在这个主线下,搜狗的竞争力在什么地方?我们的核心是一个技术方面很性感的词,叫做“语言”。今天做图像挺多的,做语音也挺多的,语言在这里面是最大的挑战,但当你看到一个小的机器,想知道它智不智能,首先跟它聊两句,如果能跟你对话,能回答你的问题,你觉得它很智能。这是我们本性对智能的理解。图灵测试当中提到,语言有什么魅力呢?第一,亚里士多德讲,语言是心灵印象的符号。因为有了语言之后,我们认知这个世界,不同的语言建立不同的世界观,我们可以说没有语言,我们没法对这个世界产生抽象的描述和表达的。所以,语言是我们认知世界很重要的部分,它也是知识的载体,是我们思维的工具。语言是对我们认知世界里不可或缺的一种符号。语言是我们心智的一种表达方法。同时语言又是人类社会中间进行沟通的一个基本工具,是社会组成的一个成分,没有语言我们形成不了社会大家进行交流。

在人工智能领域里提到语言是人工智能皇冠上的明珠,第一,很重要。第二,也很难。甚至我们可以说,没有语言我们就没有能力去做创造力和推理的能力。今天大家认为人工智只能解决重复性的事情,就是因为人工智能还没有创造力和推理能力,背后就是对语言还没有完整的了解。

这是我们在这里要解决的问题。为什么我们感兴趣语言,做什么事呢?

搜狗之前做了输入法,做过搜索,一个是用语言帮助你去表达信息,一个是用语言帮你去获取信息。因此在这里面我们有很好的场景,是在语言里面帮助你做输入和输出。今天在整个人工智能领域里面提到两个核心概念,一个叫感知问题,模仿人的大脑的连接与深度学习方式里获得语音图像的能力。

另外一个事情是知识计算,在语言之上提取出语言之间的关联关系,然后产生后面的推理能力和知识的关键能力,这称之为计算能力。

前面讲的是干知,后面讲的是认知。

搜索从2012年开始提出自己的核心理念的时候,就围绕着自然交互和知识计算去发展我们自己的核心语言AI能力。自然交互里做的核心是跟图像和语音相关的,语音有语音合成、语音识别包括整个变声的技术。一会儿给大家介绍当前最前沿的技术在商业领域做了什么样的度,以此来理解互联网公司、技术公司现在把这样一个研究成果转化到应用的可能性。另外,在图像里面比较简单的人脸识别做的比较多,搜狗不是发展这个,我们更多是在做OCR,做文字的理解,或者是做唇语识别,通过看你嘴唇的运动能知道你在说什么,还是跟语言相关。

另外更难的是跟知识计算相关的,把对话、问答、翻译,这些事情这几年大家看的比较多,应该是在知识

计算里最简单的一件事情。搜狗做了很多更深的工作,包括翻译里的同传,AR还有视觉翻译,包括还有实时同传的翻译,以及像搜索里面用中文搜索全球信息的翻译等等,基本上可以展开语言为核心的AI的布局图。

现在可以看一看一些有意思的前沿的成绩。今天我们每天的语音识别请求已经超过了8亿次。

这个技术是语音识别,第一响应的是要识别得准,声音小都能识别。但今天更高的要求是在里面提取出更多人和语义来。第一件事情,大家看到有人的分割,不同的人说话的时候它能知道这是第一个说话的人,这是第二个说话的人,是通过他的声纹做一个切割。

第二,在中间的时候能把笑声、掌声、音乐的声音都能给识别出来。识别的不只是语音的文字,而是其它结构化的信息,甚至可能一个狗叫,也能告诉你这是什么叫的声音。

第三,很难的点行业前沿在做,就是中英文混合,如果不对这个技术了解,觉得这是挺简单的事情,但是中英文混合识别的时候,其实调动的不是语音识别感知的系统,而牵扯到认知结构,这个技术已经超过了今天深度学习这样一个浅显的能力,把这个做到,今天搜狗包括其它的友商,像讯飞,大家努力的一个方向,中英文混合对今天的语音识别引擎是非常挑战的一件事情。

另外,AI还带来什么东西呢?降噪算法。以前的声音降噪是靠麦克风矩阵做多个点声音的降噪。今天在一路声音里,也能作为背景声去除。我们可以看这样一个真实的算法的结果。

这个基本上是一个听不清的状态,但是我们通过算法过滤之后,基本上讲的是针对现实场景中四万亿种真实的噪音进行降噪,AI做法跟传统不一样,传统做法是靠硬件去严格的信号计算。AI是建构的场景能够消噪,我们的工程团队对大量的噪音进行了学习工作。

一个小小的录音笔里面其实会藏很多的技术进去,才能够把这样一个对于声音的理解做到极致。2、3月份发的技术款里已经有大部分的能力了。这就是说明AI进去之后能够重塑这样一个行业。

语音识别之外我们谈到语音合成,也是前沿的工作。今天有技术能做到在线、离线、男女各种风格甚至多种语种声音的合成。这个事情中间还有一个难点的事情,就是如何把一种声音把情感带进合成另外一个人的声音。怎么理解?一个人在表达他的情感,因为机器不具有情感表达能力,但是用声音皮肤感贴上去合成另外一个人,形成另外一种效果,这是行业前沿的能力。

这是一个原声。今天机器不是在合成,合成这么一个有情感的声音,机器今天做不到。但是今天机器可以把一个声音通过皮肤的方式变成其它的声音。这是什么技术呢?这是用了声音皮肤,把原来的一个带有情感的声音给它做一个改变,把其它声音带进去,变成高晓松的声音。

我今天讲这个东西能干什么用呢?它能够干很多讲故事的事情。这是凯叔的原声,用小川的声音做训练,大家可以理解,把这样的声音合在一块儿就可以变成王小川讲故事。这里面想说一个什么事呢?因为今天的语音技术、人工智能技术还没有能够承担表演的职能,只能做一些简单的合成,因为表演要深刻的理解。现在既然做不到,我们会采用其它方法,就是让人去承担这种表演,但是可以用另外一个声音把它套上来变成一个标准品的输出。这种东西是有机会去改变整个行业音频的生产制作的模式的。以前而言,声优变得特别关键,声音很好听,他跟你签约之后,如果这个声优走了,你可以把声优的声音采集下来变成你的数据产权,这时你可以找任何一个人生产这样一个音频,把声优的声音贴上来,这个在行业里潜移默化也会带来一个变革的方式。

有了这个技术之后我们做了一个里程碑的尝试,在语音合成里面做播报没有问题了,大家都听过高德地图里林志玲的女声做播报。但是在一个表演,在一个付费的音频节目里,机器达不到像人表演一样的高度,那这个里程碑的尝试怎么做的?实际上这个技术的做法,首次是用一个转述师,另外一个人读这样一个内容,随后把梁宁的声音附上来。这个事情是一个破天荒的工作,把人的创作工作和一个表演和声音合成。

再有一块工作是搜狗今年做的比较重要的工作,是搜狗的分身技术。分身技术是从一个语音合成开始走向了一个对真人的视觉的合成。这不是一个真人,整个这个视频制作是合成的,有真实的原型,这是新华社的主持人,用她的视觉和她的声音,我们经过建模之后,能够完整地获得她的视觉合成的能力。只要你输入一段文字,就能合成这样一个视觉去播报。这个播报确实真的实时在新华社已经取代了她在新华社APP里的播报,到现在已经播报了3000多条的内容,全球首个取代人的主播,得到了国际商BBC、CNN等200多家主流媒体的报道。在这个领域里也有网友表示,能不能把一个娱乐记者,把一个网红的直播给取代呢?我们说今天其实做不到。今天能做的还是这种重复性的没有创造性的劳动,对于一个有创造力或者是需要有表演才能的工作,今天机器是没法取代的。

还有一个重要的工作,是和情怀相关的,就是语言的工作。这是搜狗的使命当中,我们认为是需要不断突破的。有一个数据,全球现在77亿人,其中中国人口第一大,大概占了20%,15亿讲中文的人。第二大母语是西班牙语,第三大是印度语,第四大才是英语,英语母语的人大概只占到全球4%。但是对不起,今天由于历史的原因,95%的网上信息表达是用英文写的,100%的商贸活动是用英文写的。因此,对中国人而言我们每个人要学好多年的英文去跟这个世界进行交流,我们会觉得有一个责任是能够使得中国人如果你不需要深入到当地生活,要去研究语言,你更多可以用机器辅助你做这样的事情。

2016年的时候我们是全球首个发布了从中文到英文的同传系统,在世界互联网大会展示,17年做了跨语言搜索引擎,你可以用中文搜索一个全球的信息,英文信息或者日韩信息,翻读。10月份的时候发布了首个离线的基于深度学习的翻译机。到了去年三季度的时候,也是全球首个能够英中同声传译的系统。到现在中英翻译开始在一些不严肃的场合,已经开始进入到了使用。

但与专业人士比较起来今天它有局限性,但是对大部分人来说,它已经可以产生超越的作用了。

前面越谈越深入,谈到翻译,更难的事情还是未来走向对话。以前我们的输入是靠输入关键词,给你十条链接,我们习惯搜索很多年了。但是这种做法的天花板是低的,因为关键词并不能够很好地表达你想提出的问题,比如我见到社长,我说社长啥事?我就说五个字:中国企业家,社长会一脸懵的样子说你问啥。今天机器没有办法列出一二三四五(3.120, 0.04, 1.30%)答案给你。走向交互,机器要辅助人,以人的语言方式进行沟通。因此会把问答作为中间的一个媒介,让机器辅助人提出好多问题来,再给你好的答案。问题越长,对机器今天的AI能力要求越高,以前关键词做不到,现在随着深度学习的发展,对语言初步的处理是可以产生这种简单的对话和问答能力,有机会在搜索行业里做改变。以后问题、答案会变成我们常用的一种跟机器沟通的方式,也是自然交互的升级,是用了知识计算的能力。

我们之前就做到了在垂直领域当中对事实类的问题,有精确答案的问题,机器可以产生超越人的回答。这个问题有明确的答案,不是一个意见性的东西。它有超越人的地方,但是又有严重跟人相比不足的地方。未来在语言相关的地方,很多时候是靠人机耦合互动的对未来人的帮助。

两个极致,在知识计算里,自然交互走向极致之后,今天大家努力的方向叫个人助理、VPA,各大主流的公司都以VPA作为自己TO C人工智能战略的极致点。沿着这个路径,还可以衍生出很多产品来,搜狗在这里面也希望给每个人提供一个更好的个人助理,以及给每个人更好的分身。

给大家汇报一下我们对前沿科技的这样一个进展的掌握和实践。

陈威如:小川,非常谢谢你刚才前沿而且振奋人心的演讲,很佩服。我刚才听到你说的很多都是注重在语义的解析还有翻译,在以后的AI的机器人的时代,你注重的这部分刚好就是像是一个机器人的脑,我觉得特别棒。假设人在跟机器沟通的时候,一般来讲沟通分为认知,就是你说的语义。另外,情绪,这是两个东西。举个例子来讲,比如说“小姐,我能够邀请你去看电影吗?”这位小姐说“好啊,试试”。另外一个说“好啊,你试试(愤怒)”情绪不一样,但是语义一样,不知道我们公司会不会在这两方面都做一些发展。发展情绪的认知跟发展语义的认知,这两个是完全不同的技术架构?还是说这两个是可以融合的?

王小川:从技术上讲我们都可以去做。你说“好呀”(大声)还是“好呀”(温柔)。今天机器在语言识别、语言合成都可以把它变成一个数字去掌握它。根本的问题不在于机器是否能够对情绪有所识别或者合成,而是说他从事的工作是否是作为一个陪伴性的任务。如果是做一个客服,如果你让机器很温柔讲话,没问题,只是一个客服。但是如果做成本身做一个人性化的工作,做一个销售,做一个阿姨,做一个保姆,做一个幼儿园的老师,这个事好像做不了。因为更多首先不是从这样一个是否有情绪的技术点去看这个问题,而是机器跟人互动中间,你对机器的要求是一个足够有人情味的开放的问题,你即便合成这个声音,也做不到。但如果它本身很窄,就是一个客服或者他就是一个电话能跟你沟通的服务员,只要你对它不要求背后有强烈的人情味的这样一种人性的需求,只是声音要满足,我们就可以做到。

陈威如:你已经做到了以后可以做问答,我在想说未来有没有可能我们真的能创造一个机器人,他是我们的心灵伙伴,他能理解你的情绪、理解你的意思,他是你世界上最好的朋友,你觉得有可能吗?

王小川:以人类已知的技术现在做不到这个事情。机器本身对语言的理解已经很难了,而且要理解人的心灵。现在并没有任何原理支撑做这样的事情。一旦做到了,系统性地取代人类,人类是机器文明的预加载程序,要么说这个人的世界人为主,机器只是作为工具,要么是机器彻底颠覆掉人,是有分界线的状态。

本文来源投资界,作者:annie,原文:https://news.pedaily.cn/201912/449344.shtml