自从去年11月ChatGPT发布以来,人工智能领域对算力的需求*提升,英伟达几乎垄断了人工智能训练芯片市场,业内一直没有新玩家或新产品对其形成有效冲击。

直至今年6月,英伟达的老对手,超威半导体(AMD)发布下一代数据中心加速处理器(APU)AMD MI300。业内认为,AMD的MI300,比英特尔和谷歌的产品更有机会挑战英伟达在人工智能领域的行业地位。

MI300是AMD发布的*款数据中心、高性能计算机群(HPC)级的APU,采用与英伟达Grace Hopper相同的CPU+GPU架构,但是硬件参数更高。

MI300在CPU部分集成了24个ZEN4内核,GPU部分集成了6块使用CDNA3架构的芯片,拥有1460亿个晶体管,比英特尔GPU Ponte Vecchio多460亿个晶体管,比英伟达H100多660亿个晶体管,而且MI300的统一内存可降低不同内存间来回复制、同步和转换数据所导致的编程复杂性。

封装工艺方面,MI300使用最近爆火的3D Chiplet封装技术,而GH200则使用CoWoS(2.5D)封装,3D对比2.5D的优势在于性能更高、延迟和功耗更低。

从硬件参数上来看,AMD MI300已经具备和英伟达叫板的能力,但显卡领域完善软件生态比堆硬件参数更难,AMD的软件生态能否贴合人工智能行业的市场需求,是MI300能否抢走英伟达既有市场的重要影响因素。

01.软件生态决定硬件市场规模

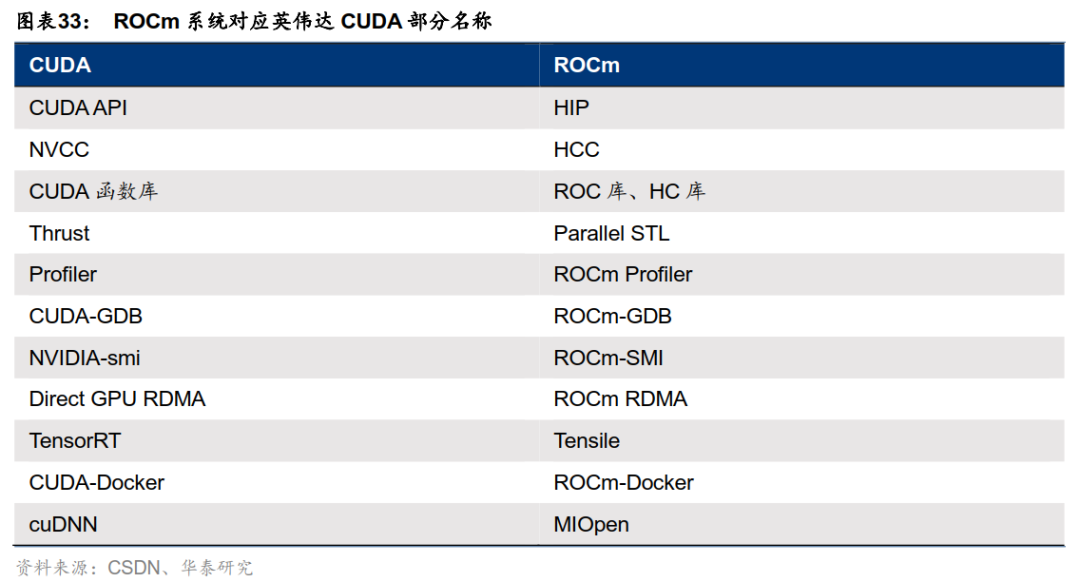

英伟达垄断人工智能训练芯片市场的主要原因是其自研的CUDA生态。所以AMD MI300想要替代英伟达,首先需要兼容英伟达的CUDA生态,AMD为此推出ROCm生态圈,并实现通过HIP完全兼容CUDA。

作为AMD的GPU软件开发框架,HIP对应的是CUDA API,其提供的HIPify-perl和HIPify-clang工具,可用于CUDA到HIP的代码转换,转码后可在AMD GPU上编译运行,基于HIP开发的应用也可用于AMD和英伟达的GPU上。

在此背景下,同一个数据中心内,理论上可以同时使用AMD和英伟达的GPU,但不同公司的GPU产品对数据精度的标准和计算方法及顺序配置不同,混合使用GPU难免会导致计算精度缺失等问题,直接影响模型训练效果。

而且从技术层面来看,兼容意味着被动、落后,因为CUDA每一次升级,ROCm都需要做出对应升级,技术团队无法将所有精力用于ROCm生态圈的迭代上,应用场景和使用体验都会落后于英伟达。

回顾二者发展历程,英伟达2007年发布CUDA,AMD2016年才发布ROCm,前者自问世起就支持Linux、Windows多平台,后者则长期只能支持Linux系统,且不支持部分Linux的更新,并于今年4月才登录Windows平台。

同样是今年4月,AMD刚解决消费级产品与ROCm的适配,此前仅支持AMD高端GPU,限制了市场份额的提升。最后就是由于切入时间更晚,AMD开发者数量远低于英伟达的400万。

对比CUDA和ROCm的开发活跃度,在全球*的开发者社区之一StackOverflow中,“CUDA”的标签下有超过14000个问题讨论,而ROCm在“amd-rocm”的标签下只有不到100个问题讨论。在Github上,贡献CUDA软件包仓库的开发者超过32600位,而ROCm只有不到600个。

为改变这种被动局面,AMD也在积极丰富其软件生态。虽然目前仅有部分SKU支持Windows系统,但主流Radeon显卡用户可以开始试用过去仅专业显卡才能使用的AMD ROCm(5.6.0Alpha)。

今年1季度,AMD宣布ROCm系统融入PyTorch2.0框架,目前TensorFlow和Caffe深度学习框架也已加入第五代ROCm。

故此,从软件生态方面来看,现有的AMD MI300还不足以威胁英伟达的市场份额,想撼动英伟达在人工智能行业的地位,AMD还需时间。

02.选择英伟达的理由

在MI 300之前,需要训练芯片的用户大多数都选择英伟达的产品,在MI 300之后,这个情况短期内也不会改变。

据华泰证券预计,拥有1600张H100芯片是AI创业公司入门水平,GPT-4级别的大模型训练则需要1.6万张H100GPU的算力,全球约有30家科技巨头和300家AI初创企业进行相关投资,未来GPU市场潜在需求达到300亿美元,英伟达或许会凭借新产品GH200继续维持极高市场份额。

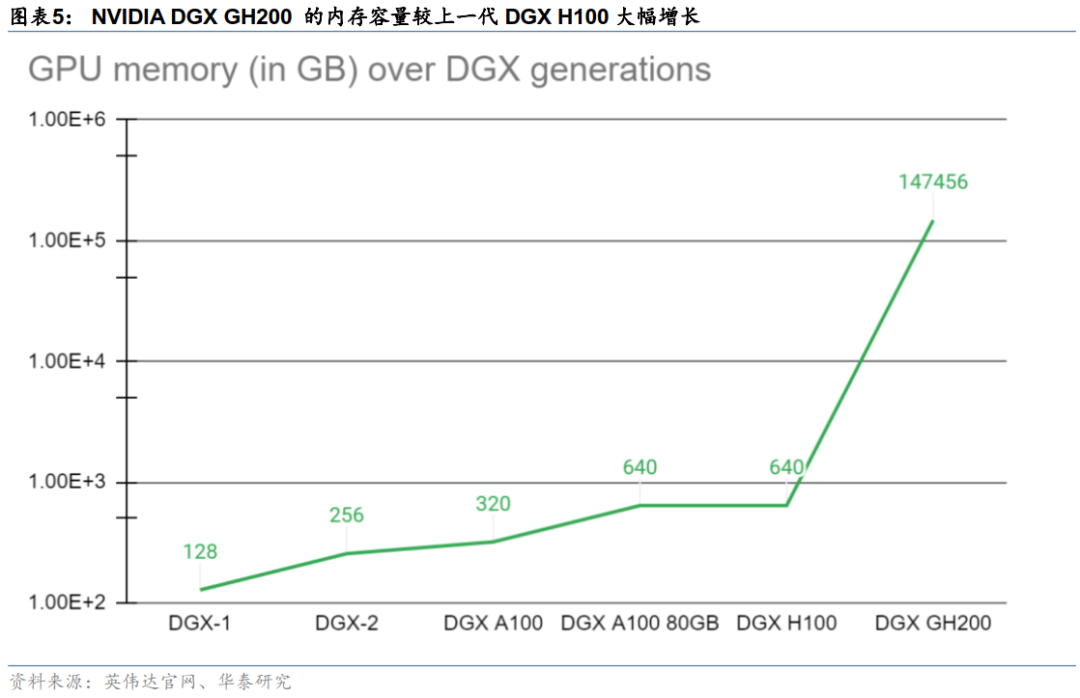

作为H100的升级产品,DGX GH200使用的2.5D的封装工艺虽然较MI300落后,但是英伟达通过 NVLink 互连技术及NVLink Switch System串联了32台由8块GH200超级芯片组成的服务器,可以为用户提供1exaFLOPS的算力与144TB的内存。

对于业内企业而言, DGX GH200提供的这种大规模共享内存解决了大规模AI的关键瓶颈,适用于对性能要求较高且资金充沛的潜在客户。目前市场有消息称谷歌Google Cloud、Meta与微软将成为DGX GH200的首批用户。

值得注意的是,谷歌目前90%的AI工作负载都使用自研TPU,且部分性能优于英伟达产品,在谷歌今年4月发布的关于TPUv4的论文中,谷歌强调TPU v4在BERT模型上比A100快1.15倍,而在ResNet模型上比A100快1.67倍,而A100的能耗是TPUv4的1.3-1.9倍。

与微软Azure中布置的A100相比,谷歌云的TPUv4在BERT上最多可节省35%的训练成本,在ResNet上最多可节省50%。除AI工作负载之外,谷歌管理层此前还曾表示TPU已广泛应用于翻译、相册、搜索、Google助理和Gmail等众多Google产品。

如果谷歌今年重新成为英伟达DGX GH200的用户,意味着DGX GH200综合表现再次超过谷歌的自研TPU。

而且谷歌重新选择英伟达还有一个理由,华泰证券认为,谷歌TPU专门针对谷歌开源深度学习框架TensorFlow进行全面优化,导致其他学习框架在TPU运行的效率或不及TensorFlow,潜在用户群不如使用A100的微软Azure。

由此可见,和使用A100的平台相比,谷歌云TPU的*优势就是成本低,这也直接体现在终端用户的使用成本上。在谷歌云上A100 80GB价格为3.93美元/芯片/小时,TPUv4价格为3.22美元/芯片/小时。

和谷歌TPU类似,AMD对MI300的定位是高性价比,试图用和英伟达相似的性能,更低的价格打开云算力设备市场。

虽然目前谷歌、微软等大厂都在积极布局云算力领域,但英伟达依旧是该领域*竞争力的企业,谷歌TPU和AMD的产品同时聚焦高性价比市场,但由于后者可以全面兼容英伟达CUDA生态,对TensorFlow之外的深度学习框架包容度更高,故此在英伟达之外的玩家中,AMD的MI300或许有机会挑战英伟达的行业地位。

结语:

在全球各大企业都涌入人工智能赛道的背景下,为其提供算力支撑的GPU行业也越来越细分。

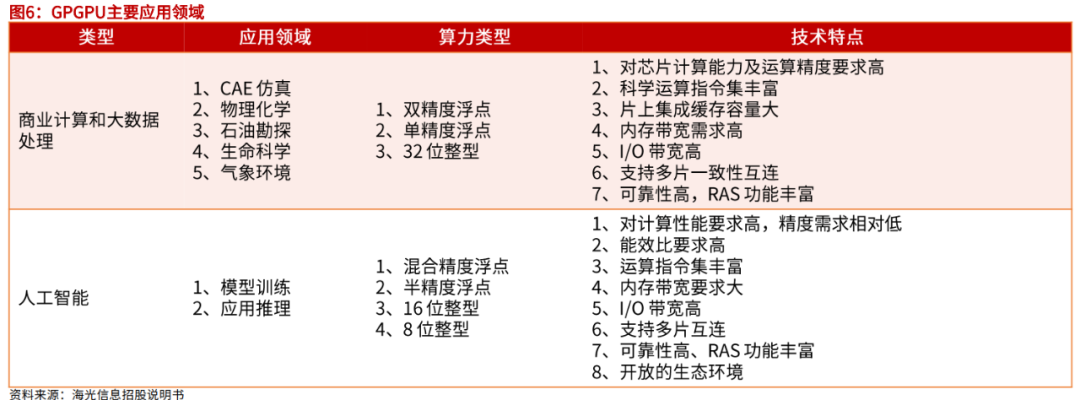

现阶段,GPU行业逐渐分化为传统GPU和GPGPU两个细分市场,前者延续专门用于图形图像处理用途,内置了视频编解码加速引擎、2D 加速引擎、3D 加速引擎、图像渲染等专用运算模块。

后者作为运算协处理器,并针对不同应用领域的需求,增加了专用向量、张量、矩阵运算指令,提升了浮点运算的精度和性能,以满足不同计算场景的需要,英伟达的GH200和AMDMI300均属于这个领域。

作为人工智能领域最主要的协处理器解决方案,GPGPU占据人工智能90%以上的市场份额。这主要是因为GPGPU能提供的完善软件生态系统,极大降低了各种已有应用程序的移植和新算法的开发门槛,这也是英伟达不断升级CUDA的主要原因。

伴随AI浪潮持续推进,各类模型训练需求与日俱增,根据前瞻产业研究院的数据,未来几年内,中国人工智能芯片市场规模将保持年均40%至50%的增长速度,到2024年,市场规模将达到785亿元。

行业景气度持续上升的背景下,谁能率先完成独有的软件生态,谁就有可能挑战英伟达在训练芯片行业的市场地位,目前看,最有机会的就是AMD。

【本文由投资界合作伙伴微信公众号:DoNews授权发布,本平台仅提供信息存储服务。】如有任何疑问,请联系(editor@zero2ipo.com.cn)投资界处理。