“GPT-4o的特别之处,在于它将GPT-4级别的智能带给了所有人,包括我们的免费用户。”

北京时间5月13日凌晨,早有预告的OpenAI春季更新如期而至。

在这次总时长不到半个小时的发布会中,圈内最熟悉的公司首席执行官山姆 奥特曼(Sam Altman)并未现身,首席技术官穆里 穆拉蒂(Muri Murati)及两名研究主管马克 陈(Mark Chen)和巴雷特 佐夫(Barret Zoph)三人围坐,共同介绍了这次更新:

推出桌面版ChatGPT & 网页端UI更新,以及最重要的,发布GPT-4o。

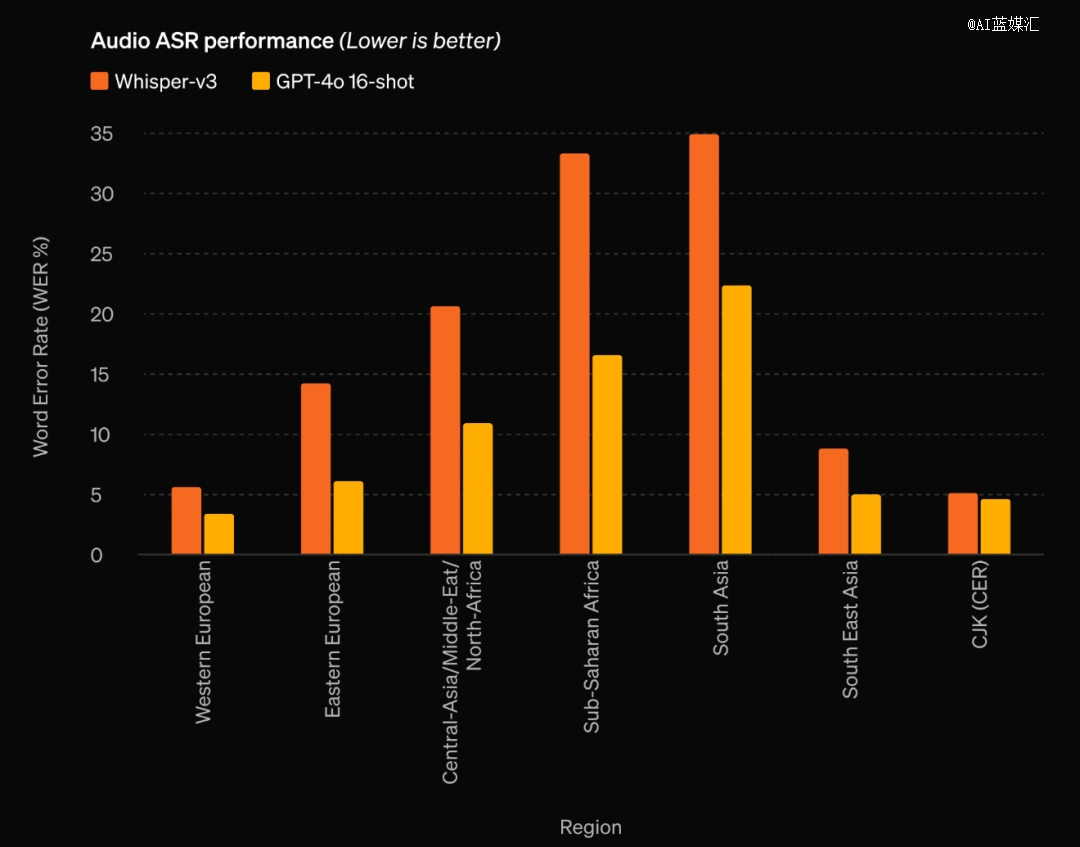

其中的“o”代表“omni”,意为全能的。根据OpenAI官网给出的介绍,GPT-4o可以处理文本、音频和图像任意组合作的输入,并生成对应的任意组合输出。特别是音频,它可以在短至232毫秒的时间内响应用户的语音输入,平均320毫秒的用时已经接近人类在日常对话中的反应时间。

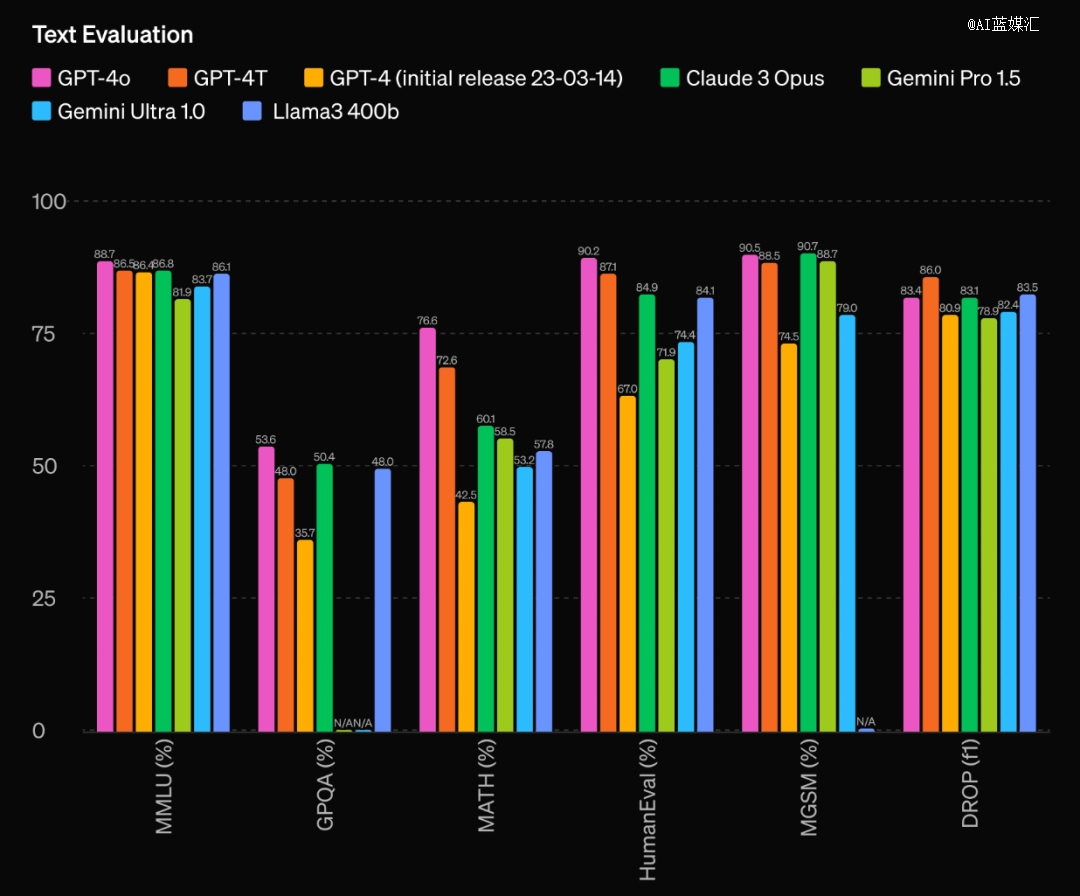

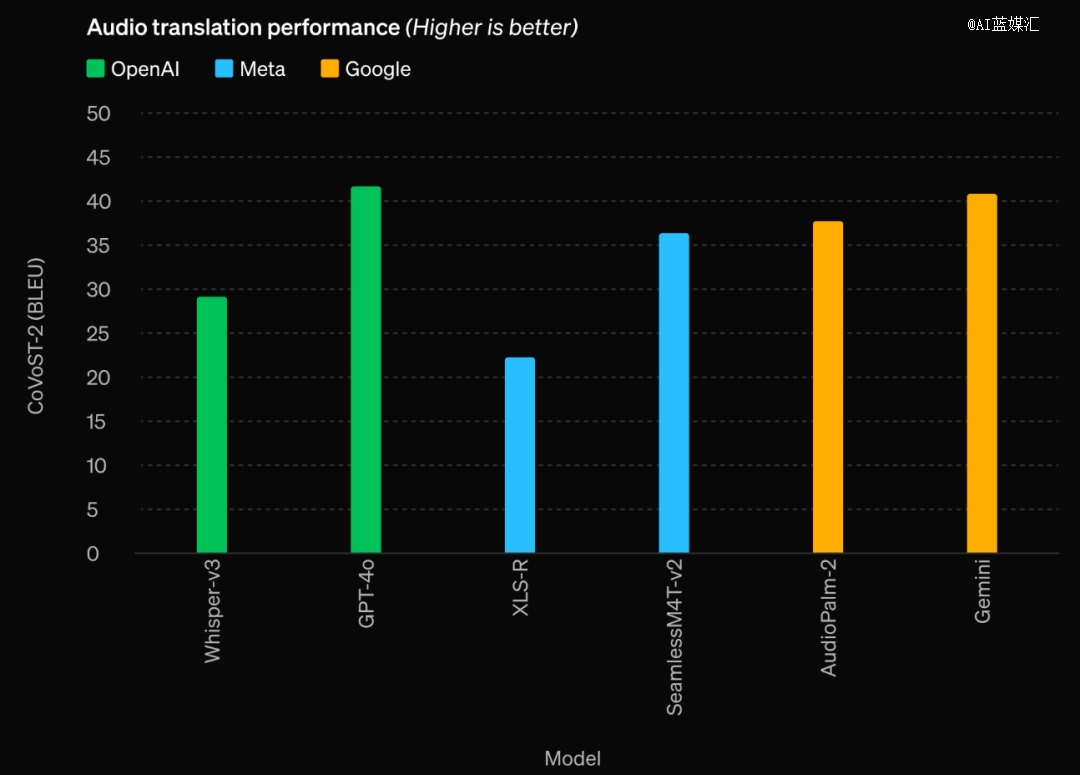

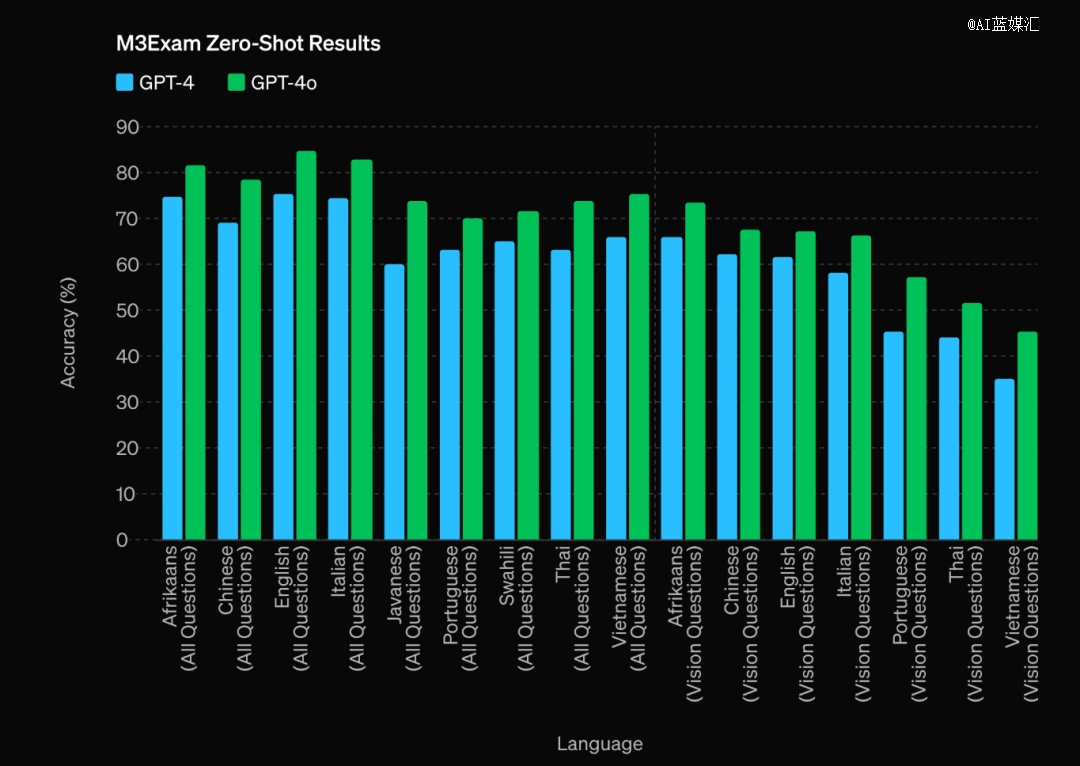

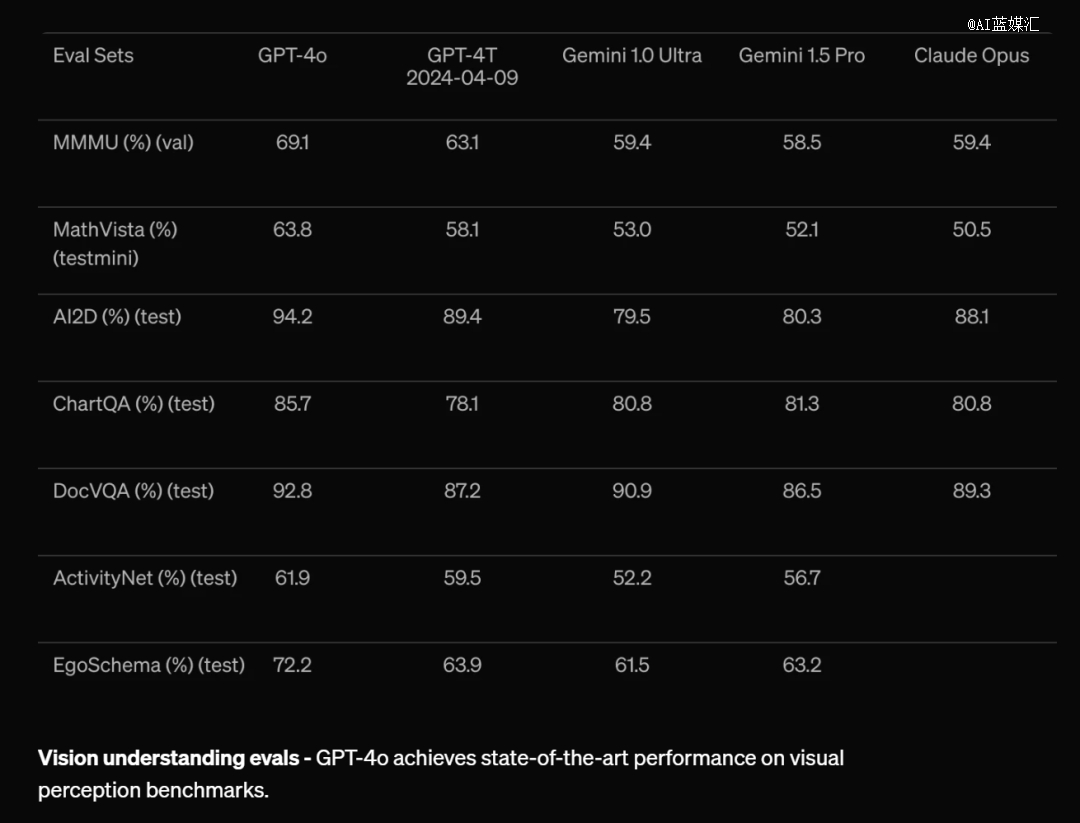

与现有模型相比,GPT-4o在视觉和音频理解方面尤其出色。

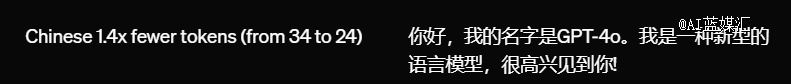

此外,GPT-4o在英语文本和代码上的性能也与GPT-4 Turbo处于同一水平线,在非英语文本上的性能有着显着提高,同时API速度快,速率限制高出5倍,成本则降低了50%。

穆里 穆拉蒂表示,OpenAI使命的一个非常重要的部分,是让他们的高级人工智能工具能够向所有人免费提供,让人们对技术的能力有“直观的感受”。

关键词:更快,更强,还免费。

当然,目前官方给出的免费限制在一定的消息数量上,超过这个消息量后,免费用户的模型将被切换回ChatGPT,也就是GPT3.5,而付费用户则将拥有五倍的GPT-4o消息量上限。

实际上,早在去年九月末,OpenAI团队就已在官网发布过一片文章,介绍当时的ChatGPT的语音对话和看图识图功能。

在此前参加播客节目“All-in Podcast”时,山姆 奥特曼曾谈及了ChatGPT的多模态交互能力,以及对包括GPT-5在内新一代AI产品更新的态度。

对于ChatGPT已有的语音功能,播客主持人表示他和家人很喜欢这个功能,尽管应用时不时还会出现一些延迟问题。

奥特曼当时回应称,OpenAI会继续改进并提升语音功能的质量:“我相信,语音交互是通向未来交互方式的一个重要线索。如果能够实现真正优质的语音互动体验,将会是一种与计算机互动的全新方式。”

对于响应速度不够快、对话缺乏流畅度和不自然的感觉,奥特曼表示团队正努力改进,致力力于让这些方面的体验得到显著提升。

现在,就像他本人在X平台上的预告,新发布的GPT-4o“像魔法一样”。

在此前的模型中,用户使用语音模式与ChatGPT对话的平均延迟为2.8秒(GPT-3.5)和5.4秒(GPT-4)。造成延迟的原因是:语音模式是由三个独立模型组成的通道,*个简单模型将音频转录为文本,GPT-3.5或GPT-4接收并输出文本,第三个简单模型再将该文本转换回音频。

这个转录再转回的过程,导致GPT-4丢失了其中的大量信息,无法直接观察音调、多个说话者(的音色区别)或背景噪音,也无法输出笑声、歌唱或表达情感。

而借助GPT-4o,OpenAI跨文本、视觉和音频,端到端地训练了一个新模型。所有输入和输出都在该模型中交由同一神经网络进行处理。

因此,新发布的GPT-4o模型,可以做到随时开始或打断对话,识别说话人的语气、情绪,根据场景或指令生成多种音调、带有丰富人类情绪特征的音频回复(甚至可以要求GPT-4o唱歌)。

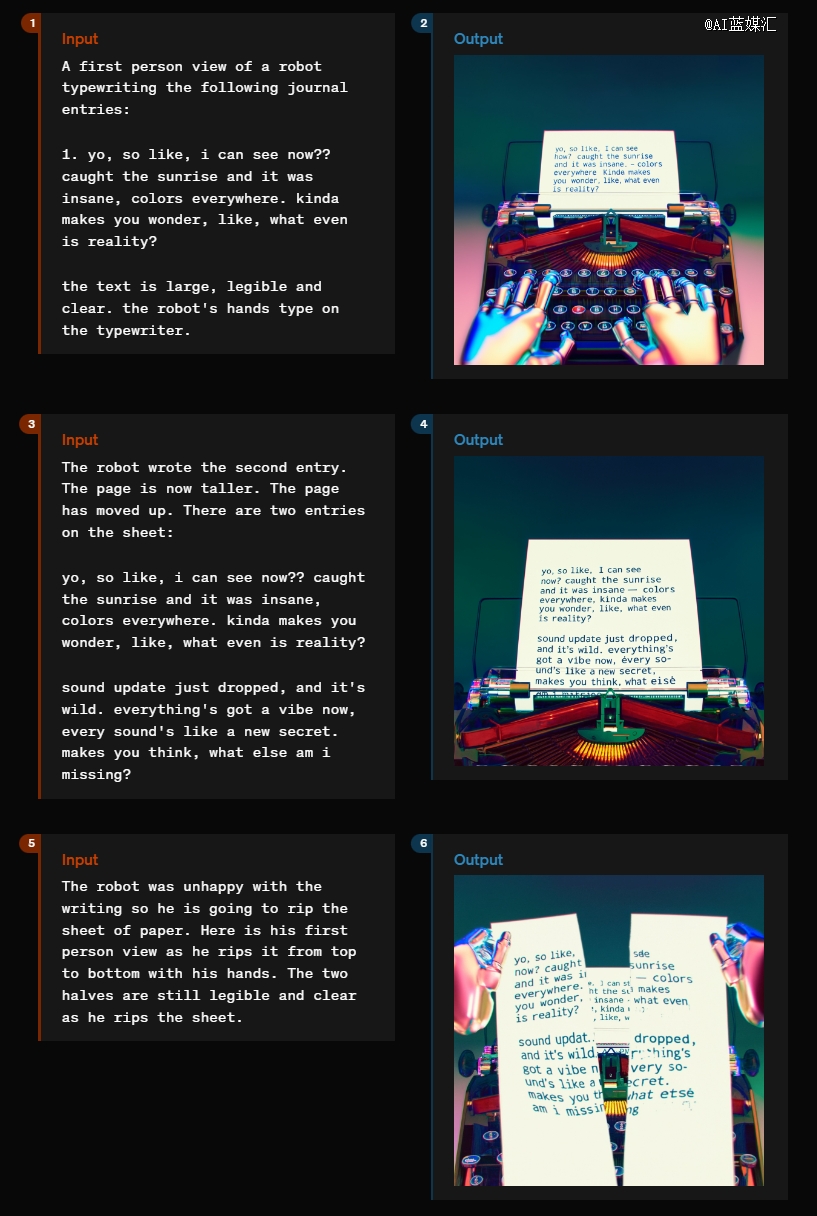

图像处理层面,在传统意义上识图的基础上,GPT-4o可以识别手写体(如解答手写的方程组)、精准分析数据,并能够读懂画面中人物的面部表情。

数据层面,根据传统基准测试,GPT-4o的性能对比GPT-4 Turbo基本都处于优势,对比其他模型更是大幅*。

根据官网给出的资料,目前GPT-4o已经支持包括中文在内的20种语言进行音频等多模态交互。OpenAI表示,这次更新“是朝着实用性的方向发展”,此次发布会主要聚焦于免费用户,新功能将在未来几周内逐步推送给所有用户。

多模态交互的上限再次被拉高,OpenAI仍是那个拥有*理解,总能先一步给出范式的玩家。

接下来要期待的,或许是*个在发布会上打出“对标GPT-4o”的大模型厂商,会何时出现了。毕竟,这恐怕不只是改个PPT的事儿。

会是明天的谷歌吗?

【本文由投资界合作伙伴AI蓝媒汇授权发布,本平台仅提供信息存储服务。】如有任何疑问,请联系(editor@zero2ipo.com.cn)投资界处理。