5月,成为了AI“爆炸”的一个月。

5月8日凌晨,苹果发布了地表最强平板,采用M4芯片的iPad Pro。M4芯片带来了*的AI性能,用官方的话来说:“比当今任何AI PC的任何神经引擎都强!”

苹果发布之后的第6天,Open AI宣布最新的旗舰大模型GPT-4o来了。不仅免费可用,更是横跨听、看、说。

紧跟着Open AI,谷歌坐不住了。第二天 I/O 2024开发者大会上,谷歌宣布了Gemini系列大模型的更新。Gemini 1.5 Pro不仅面向所有人开放,上下文窗口还从100万token直接一步迈向200万,一口气能读1500页PDF。

在Open AI和谷歌的大战后的6天后,微软不声不响地再次向AI的湖水中投入一块巨石,提出了“Copilot+PCs”的概念。

这一波操作下来,网友们都开始兴奋:“事情变得有趣起来。”

微软向苹果开火

“Copilot+PCs”的概念的出现,直接掀翻了AI PC的桌子。

为什么这么说?

与此前主机厂频频展示但概念模糊的“AI PC”相比,微软给出了更明晰的定位。Windows系统层面,集成了刚刚问世的GPT-4o;在硬件层面,内置的骁龙X Elite芯片可以在不依赖云端算力的情况下,本地处理生成式AI应用。

微软的清晰定位,戳破了很多厂商还在遮遮掩掩的模糊概念,带来的两个拷问特点就是:AI PC到底需要什么样的硬件?又需要什么样智能体?

微软在发布会上,频频将矛头指向了苹果。

比如,为了体现*款Surface Pro的性能,微软拿出苹果MacBook Air一较高下。根据微软官方测试,新款Surface Pro的多线程性能相比苹果的MacBook Air高58%。

微软还强调想要被称为 Copilot+PC,至少需要提供 40 TOPs 的性能。而苹果这个月刚刚发布的M4芯片,NPU算力正好是38 TOPs。

为了能够在本地处理生成式 AI Copilot,微软除了要求需要NPU外,还至少要 256GB SSD、和 16GB RAM。这个要求,是苹果MacBook Air 的两倍。

可以说,微软抛出的条件,直击苹果的软肋。

自从今年AI PC逐渐成为个人电脑领域的热词后,苹果就一直在渲染Mac是消费者可以买到的*的AI PC。按照苹果的说法,自从2020年*款M系列的芯片M1推出时,带有NPU的M1就是为AI而生。

苹果CEO蒂姆·库克曾在今年年初提到,“目前市面上用于人工智能的电脑,没有比Mac更好的。”

要提到Mac的*槽点,非“*”的8G内存莫属。距离库克上一次升级内存已经过去了7年,这7年中Mac系列机型始终没有提升过内存的起步配置。

对此苹果方面声称,Mac使用的8GB统一内存(Unified Memory)与竞争对手的16GB内存(Memory)相当,官方给出的答复是8GB内存足以驾驭上网、播放视频、轻量编辑等很多任务。

问题是,8GB起步的内存能够支撑Mac成为*的AI PC吗?

运行AI大模型需要大容量的显存是众所周知的事情。伯克利大学的研究团队发现,未来内存墙可能将会是比算力更大的瓶颈,GPU的显存容量严重制约了可训练的模型规模和算力提升速度,或将成为阻碍AI技术发展与落地的重要瓶颈。

GPU的显存如果只有8GB水平,无论开发者如何进行优化,想要容纳一个千亿参数的大模型也只能是巧妇难为无米之炊。

如果想要配置一台能够畅玩AI 的电脑,那么大多数人的意见都会是32GB起步的内存。实际上,在2024中国闪存市场峰会上,英特尔甚至更为激进地表示,未来AI PC入门级标配一定是32G内存,而当前16G内存一定会被淘汰。

也正因此,微软将未来AI PC门槛配置提高到16GB 也不足为奇。

AI PC芯片,多少算力算够?

实际上,虽然对于AI PC 在软件、系统层面的争论还在继续,但硬件层面,厂商都不约而同达成了共识:需配备NPU、CPU和GPU的异构计算平台。

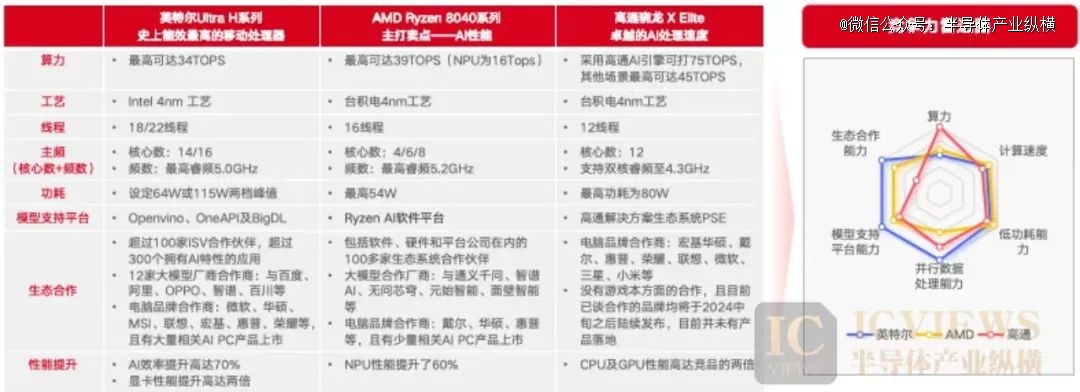

目前推出AI PC芯片的厂商有四家:英特尔、AMD、高通、苹果。不过苹果属于自产自销,因此我们不多讨论。英特尔在AI PC芯片进展中保持*,AMD相关产品迭代速度更快,高通AI PC芯片的端侧AI推理能力优于英特尔及AMD,未来预计逐步抢占更多市场份额。

市场上已公布的AI PC大多搭载的都是英特尔的Meteor Lake,比如联想小新 Pro 16 2024 酷睿 Ultra 版、联想高端线 YOGA 、微软的两款PC Surface Pro 10商用版和Surface Laptop 6商用版、华硕灵耀14 2024 AI超轻薄本等。

这是英特尔在2023年年底发布的Meteor Lake,采用Intel 4(7nm)制程工艺的计算模块,多达 6 个性能核,8 个能效核,以及 2 个低功耗岛能效核,一共加起来会支持 22 个线程。

目前,Meteor Lake AI PC已经赢得了100多家ISV独立软件供应商的支持,AI加速功能已经超过300项,AI大模型加速优化已经超过500项。

AMD也提供 AI PC的芯片。AMD在去年推出了锐龙7040,同样搭载NPU。此后,AMD又发布了锐龙8040处理器。锐龙8040系列开发代号Hawk Point,仍然基于Zen4 CPU架构、RDNA3 GPU架构、XDNA NPU架构。目前,搭载AMD 锐龙8040处理器的AI PC包括华硕ROG幻14 Air笔记本、华硕天选、华硕a 豆、华硕无畏。

此外,AMD相关产品相比友商更新迭代速度更快,例如在美国东部时间4月16日,AMD宣布推出两款新产品锐龙(Ryzen)Pro 8040系列和锐龙Pro 8000系列,惠普、联想等厂商会在今年年底前推出搭载锐龙Pro 8040系列芯片的AI PC。

高通的AI PC芯片是在去年10月发布的骁龙 X Elite/X Plus。由台积电4nm工艺制程打造,搭载了全新定制的Oryon CPU,在4+4+4的三丛集中,12颗核心的主频均可达到3.4GHz。

目前,搭载骁龙 X Elite/X Plus的AI PC包括宏碁 Swift 14 AI 笔记本,以及微软刚刚发布的Windows 11 AI PC。据了解,Windows 11 AI PC自6月18日起陆续上市,微软Surface以及戴尔、宏碁、华硕、惠普、联想等OEM合作伙伴将陆续推出Windows 11 AI PC。

前文提到,微软认为真正的AI PC需要算力达到 40 TOPs。这对于AI PC的芯片层面提出了一个新的要求。

我们来看看,目前主流的Meteor Lake、锐龙8040、骁龙 X Elite/X Plus的算力情况。

英特尔Meteor Lake的综合算力在34 TOPS左右,NPU算力在10TOPS左右,官宣可以支持200亿大模型在终端侧运行;AMD的锐龙8040的整体算力在39 TOPS,NPU的AI算力在16 TOPS;高通骁龙X Elite NPU的算力则达到了45TOPS,官宣可支持130亿参数大模型的本地运行。

芯片企业竞争力分析对比图

芯片企业竞争力分析对比图

总体上来看,芯片算力层面,高通优势最为突出。计算速度层面(频率),AMD处理指令的速度更为突出。功耗层面,AMD芯片优势突出。核心数方面,英特尔的并行处理数据能力更强。

值得注意的是,英特尔已经宣布了自己的下一代笔记本芯片Lunar Lake,将可以提供超过100 TOPS的性能,其中神经处理单元(NPU)能够提供45 TOPS。而这一性能,也达到了英特尔此前在台北人工智能峰会上提出的下一代AI PC所需的45 TOPS NPU的性能门槛。

实际上,根据《AI PC产业(中国)白皮书》,当端侧混合AI算力达到10TOPS,可以在本地完成如设备智能管理、图像增强、游戏调优等特定场景的 AI模型推理任务;AI算力达到 40TOPS 时,可以在与GPU或云端配合情况下,完成工作、学习、娱乐等场景的大部分 AI 创作类的需求。

这么来看,真正成熟的AI PC芯片算力至少会比当前再提升一个水平。

AI PC在期待什么?

在1月初,微软往 Windows 键盘塞了一枚全新的 Copilot 键,迎来近三十年的首次改版,只需点击一下按钮,用户就可以和 Copilot 进行无缝亲密的互动。而现在,微软的 Copilot 键,用户可以直接访问包括 OpenAI 的 GPT-4o 在内的最新模型。

微软是*将GPT-4o快速整合到终端的企业,当然,考虑到微软和Open AI的关系,双方的合作应该很早就已经开始。

实际上,无论硬件层面如何要求,一台PC上能够在本地运行、搭载大模型才能算一台合格的AI PC。在分析机构看来,未来的AI PC产品将更像是用户的个人AI助理,这需要将个人大模型、个人知识库、个人Agent嵌入到设备中以实现AI PC的多模态自然语言交互,大幅提升意图理解能力。

AI PC是大模型向终端转移的*步。

从目前市场上的端侧大模型来看,一个符合常理的规律是:设备端越大(功能越多),其端侧大模型的参数量也越大。例如最近商汤亮相的“日日新5.0”,采用混合专家架构(MOE),是国内*全面对标甚至超越GPT-4 Turbo的大模型,参数规模达到6000亿。

上千亿参数的大模型,对于PC来说,显然并不适合。

我们可以来看看目前发布的能够搭载大模型的PC。华为的*AI PC产品MateBook X Pro上,支持华为自家的盘古大模型以及文心一言、讯飞星火、智谱清言等第三方合作大模型。在个人智能体方面,华为AI PC的电脑管家中设有AI空间,内置100多个智能体,覆盖文案创作、编程等多种能力,为用户带去AI新体验。

联想通过大模型压缩技术对阿里通义千问大模型进行压缩,压缩后的大模型称为Lenovo AI Now模型,加上在个人智能体方面,联想发布了业内*AI PC个人智能体——联想小天。

荣耀发布的AI PC 产品MagicBook Pro 16中,搭载荣耀语音助手「YOYO 助理」,帮助用户完成语义搜索、文档总结、服务推荐、辅助创作等。

200亿的参数已成为AI PC目前可以支撑的较高水平,对于大模型厂商来说,如何提供轻量级大模型是一个问题。

目前的主流方式是借助大模型压缩技术,可以在不显著降低模型性能的前提下,节省存储空间、提高计算效率、加速推理过程。比如知识蒸馏、模型量化和权重剪枝等,将数据类型转化为int8甚至int4,从而进一步减少推理过程中的算力需求。

如果能够将更多复杂的大模型在PC端实现高效运行,那么未来除了OpenAI的GPT系列,阿里云的通义千问、腾讯混元、百度文心系列等等,都有可能成为端侧AI PC的重要组成部分。比如,在大模型、AIGC应用方面,荣耀就已同百度达成合作。

现在购买AI PC的人,是先驱还是韭菜?

在早期大模型还没有如此火热的是很好,很多爱好者和研究者都会自己组装,选择在本地电脑上折腾这些开源大模型或者开源项目。

那么,在市面上攒一台可以训练个人大模型的台式机,大概需要多少钱呢?粗略计算各组件的成本如下:

可以看到,组装一个本地跑大模型的台式机价格大概在1.1万到4万之间。通常来说,台式机不需要考虑便携性和体积,价格要比笔记本电脑便宜。

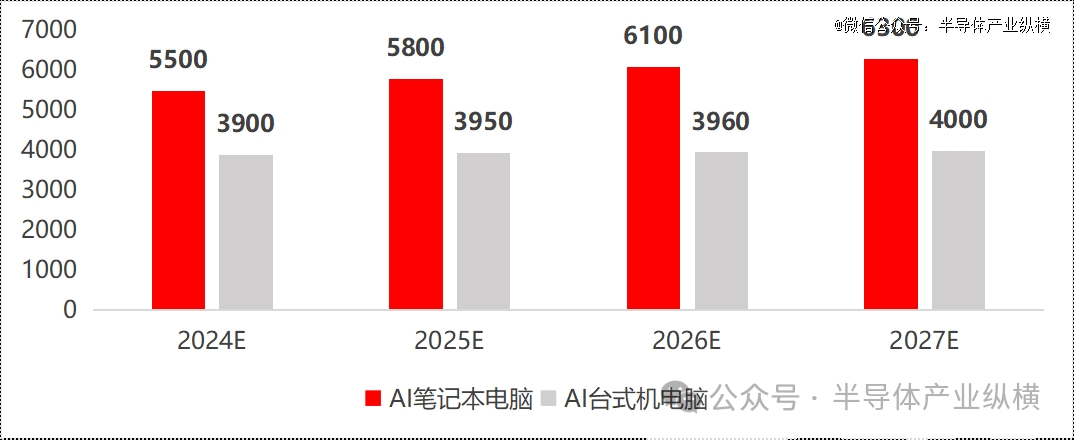

信息来源:IDC

信息来源:IDC

IDC对于价格方面比较保守,从IDC统计的数据中,AI笔记本电脑平均销售单价将在5500~6500元区间,AI台式机电脑平均单价约4000元。

不过目前公布的AI PC价格来看,以定位比较高端的ThinkPad X1 Carbon AI 2024 为例,顶配的32GB+2TB 版本,售价为16999 元。新发布的YOGA Book 9i,最高售价为17999元。而华为新发布的MateBook X PRO的高配 Ultra9 32GB 2TB为14999元。如果购买微软的Surface Pro,想要搭载 X Elite 芯片和 OLED 屏幕的话,最少要花费 11088 元。

虽然调研机构预计2024年以后需求增长和性能提升将推动AI PC销售均价继续提升,但是整体会呈现“初期高定价,中后期价格下降”的趋势,下降幅度取决于芯片等硬件设备方面的降本空间。但是在AI PC刚发布初期,这个价格和性能还不足以让消费大众砸钱换新机。

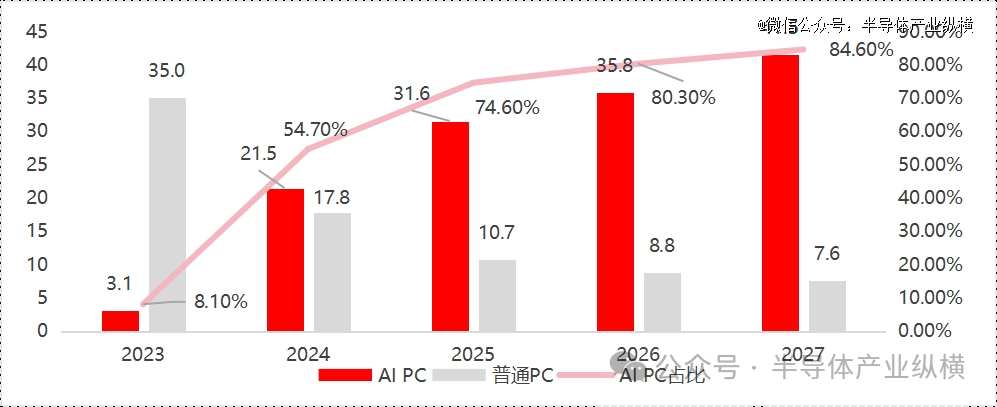

观AI PC全局

伴随着AI CPU与Windows12的发布,2024年将成为AI PC规模性出货的元年,2027年AI PC将成为主流化的PC产品类型,未来五年全球PC产业将深入迈入AI PC时代。IDC预计未来五年全球AI PC的复合增长率将达到126%,中国AI PC市场渗透率预计将于2027年增长至85%左右。AI PC将成为全国及中国PC市场发展的主要驱动力。

中国AI PC市场出货量及占比预测 信息来源:《AI PC产业白皮书》

中国AI PC市场出货量及占比预测 信息来源:《AI PC产业白皮书》

硬件层来看,处理器芯片、内存、散热、交互将是主要收益领域;模型层来看,未来针对各行业的垂直端侧模型将成为主要发展趋势,进而支持传统软件的AI转型以及AI原生应用的发展;终端层来看,各主流PC厂商玩家正加快AI PC相关产品布局。

AI PC产业链图谱

AI PC产业链图谱

从芯片生态能力来看,英特尔Ultra芯片生态综合能力更强,拥有更多的头部大模型及AI PC品牌商等生态合作伙伴。

芯片企业生态图谱

芯片企业生态图谱

2023Q2开始,头部厂商陆续推出了ThinkPad14、EliteBook805等AI PC初期产品,且这一趋势在2023下半年开始进一步提速,各大厂商相继推出更多性能更强的AI PC新品。根据各大厂商表述与产品进展,2024年各头部厂商将推出一波采用AI加速的新机型,及时为用户提供差异化体验。

惠普、戴尔、联想、宏基和华硕都表示,计划与英特尔和AMD 的新CPU产品路线图同步推出全新 AI PC,在 2024-2025 年 Windows 更新期间产品推进市场,为加速设备升级提供机会。

AI PC产品发布路线图

AI PC产品发布路线图

AI PC玩家竞争力对比

AI PC玩家竞争力对比

应用层-应用场景及应用软件

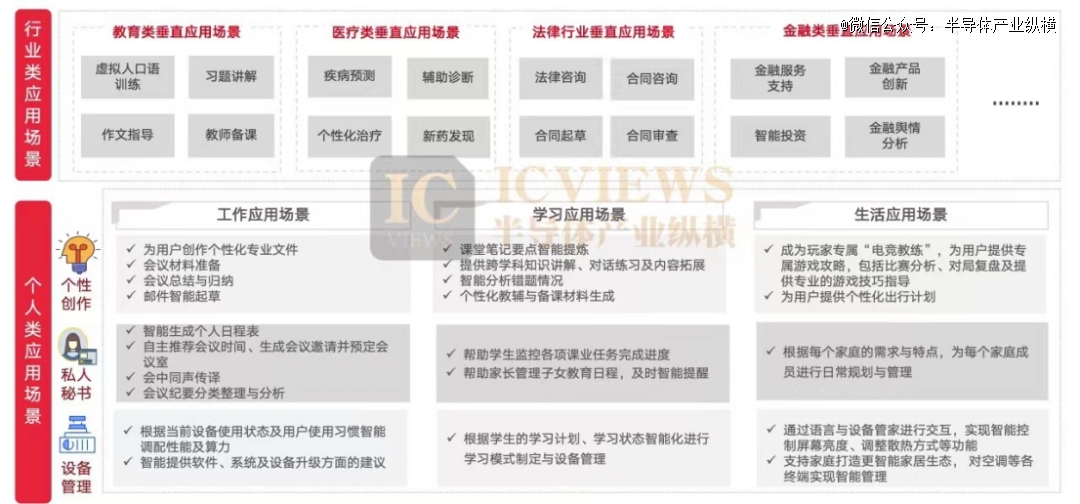

AI PC应用场景主要包括垂直行业类应用场景以及通用型应用场景。垂直类行业应用场景主要包括教育类垂直应用场景、医疗类垂直应用场景、法律类应用场景以及金融类应用场景等。通用型应用场景是指AI PC能够针对工作、学习、生活等场景,提供个性化创作服务、私人秘书服务、设备管家服务在内的个性化服务。

AI应用软件生态处于初级阶段,同时国际主流个人AI应用软件在国内受限,国内软件应用生态待发展。各垂类细分领域应用场景仍需要进一步的开发。在AIPC时代,在端侧部署本地大模型仅是基础,重要的是要构建AIOS交互界面和生态,其能调用的应用与模型数量和质量直接决定了用户的AI体验。目前还处于待开发阶段。

AI PC行业未来发展趋势

从产业链发展趋势来看,上游AI PC芯片“CPU+NPU+GPU”异构方案将成主流,并支持用户对AI PC芯片进行二次开发,同时端侧模型呈现轻量化、行业垂直化、个性化发展趋势。中游各PC品牌主流玩家均继续加速布局AI PC赛道,短期来看,联想AI PC综合实力更强,但是长期来看,具有手机品牌的电脑厂商基于其可以将手机及电脑打通的生态优势,将具有更大的AI PC发展潜力。下游政务、医疗及教育行业将成为AI PC落地场景的主要赋能行业。

从产品发展趋势来看,未来AI PC产品将主要包括两类,一类是具有高AI算力的AI PC产品,另一类是具有低AI算力的AI PC产品。高AI算力AI PC产品可运行大量垂直行业细分领域的端侧大模型,低AI算力AI PC产品的端侧大模型主要围绕语音、文字和图像处理等。

从商业模式发展趋势来看,随着未来AI软件侧及相关技术的进一步发展与落地,AI PC中的AI助手会采取与WPS类似的商业模式,根据服务的不同等级设置不同的价格。

从生态体系发展趋势来看,PC终端厂商将承担起行业生态组织者的使命,以场景需求为基础面向用户整合产业资源,成为 PC 产业生态的核心中枢。AI模型技术厂商将重点开发轻量化与针对各垂直行业的端侧大模型、提供模型个性化微调服务以及将自身模型解耦和适配AI PC个人智能体。传统应用厂商需要和模型厂商合作,将传统应用升级为大模型赋能应用;长期则需进行更为彻底的重构,将自身转型为AI原生应用。AI应用商店将聚合AI原生应用和由AI赋能的应用,并提供便捷的检索和下载支持。芯片厂商将注重建立通用、兼容的AI开发框架,并降低大模型和应用开发适配门槛模型,提供具有高效能普惠型智能算力的芯片。

从总体上来看,智能设备作为人工智能触达用户的载体,AI PC将深入变革PC产业。生成式AI和LLM的飞跃式发展,深刻变革了个人生活与工作模式,加速各行各业智能化转型。AI发展正从软件主导转向硬件+软件并行驱动,而智能设备作为AI触达用户的*载体,正成为AI未来发展与落地的重要突破口。AI PC将AI模型与PC结合,带来架构设计、交互方式、内容、应用生态等创新,将深入变革PC产业。

【本文由投资界合作伙伴微信公众号:半导体产业纵横授权发布,本平台仅提供信息存储服务。】如有任何疑问,请联系(editor@zero2ipo.com.cn)投资界处理。