近日,AI芯片初创公司Etched宣布,已筹集 1.2 亿美元,向 Nvidia 发起 AI 芯片设计挑战。

Etched 正在设计一款名为 Sohu 的新芯片,用于处理 AI 处理的一个关键部分:Transformation。该公司表示,通过将 Transformer 架构刻录到芯片中,它正在打造世界上最强大的 Transformer 推理服务器。Etched 表示,这是有史以来最快的 Transformer 芯片。

Primary Venture Partners 和 Positive Sum Ventures 领投了此轮融资,并获得了 Hummingbird、Fundomo、Fontinalis、Lightscape、Earthshot、Two Sigma Ventures(战略)和 Skybox Data Centers(战略)等机构投资者的支持。

值得一提的是,该公司的天使投资人包括 Peter Thiel、Stanley Druckenmiller、 David Siegel、Balaji Srinivasan、Amjad Masad、Kyle Vogt、Kevin Hartz、Jason Warner、Thomas Dohmke、Bryan Johnson、Mike Novogratz、Immad Akhund、Jawed Karim 和 Charlie Cheeve。

泰尔奖学金主任亚历克斯·汉迪 (Alex Handy) 在一份声明中表示:“投资 Etched 是对人工智能价值的战略押注。他们的芯片解决了竞争对手不敢解决的可扩展性问题,挑战了同行普遍存在的停滞不前现象。Etched 的创始人体现了我们支持的非传统人才——从哈佛辍学,进军半导体行业。他们付出了艰苦的努力,以便硅谷的其他人可以继续安心地编程,而不必担心他们正在研究的任何底层技术。”

Etched创始人:Robert Wachen、Gavin Uberti、Chris Zhu

Transformer一统江湖, GPU撞墙

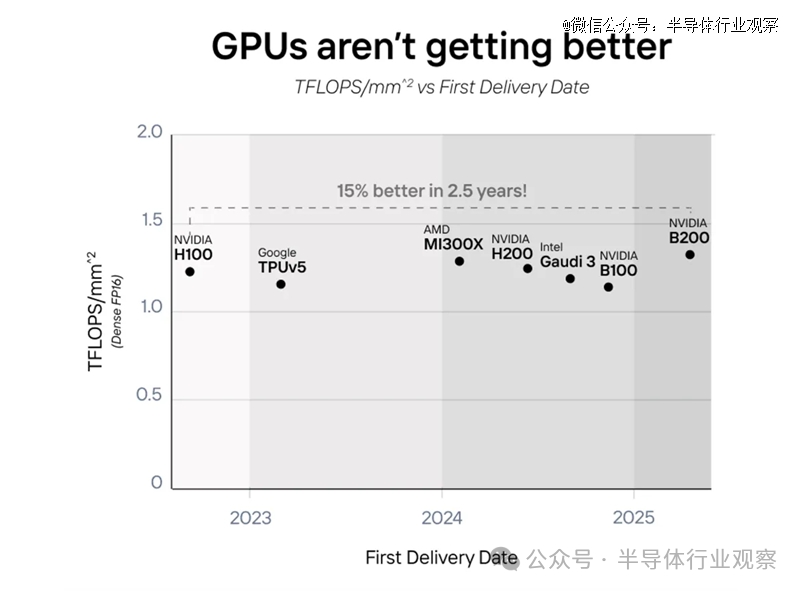

正如大家所所看到的,过去解决AI问题,都是考GPU。不过Etched在博客中表示,圣克拉拉的秘密是,GPU 并没有变得更好,而是变得更大了。四年来,芯片单位面积的计算能力 (TFLOPS) 几乎保持不变。

他们表示,NVIDIA 的 B200、AMD 的 MI300、英特尔的 Gaudi 3 和亚马逊的 Trainium2 都将两块芯片算作一张卡,以实现“双倍”性能。从 2022 年到 2025 年,AI 芯片并没有真正变得更好,而是变得更大了。2022 年到 2025 年,所有 GPU 性能提升都使用了这个技巧,但Etched 除外。

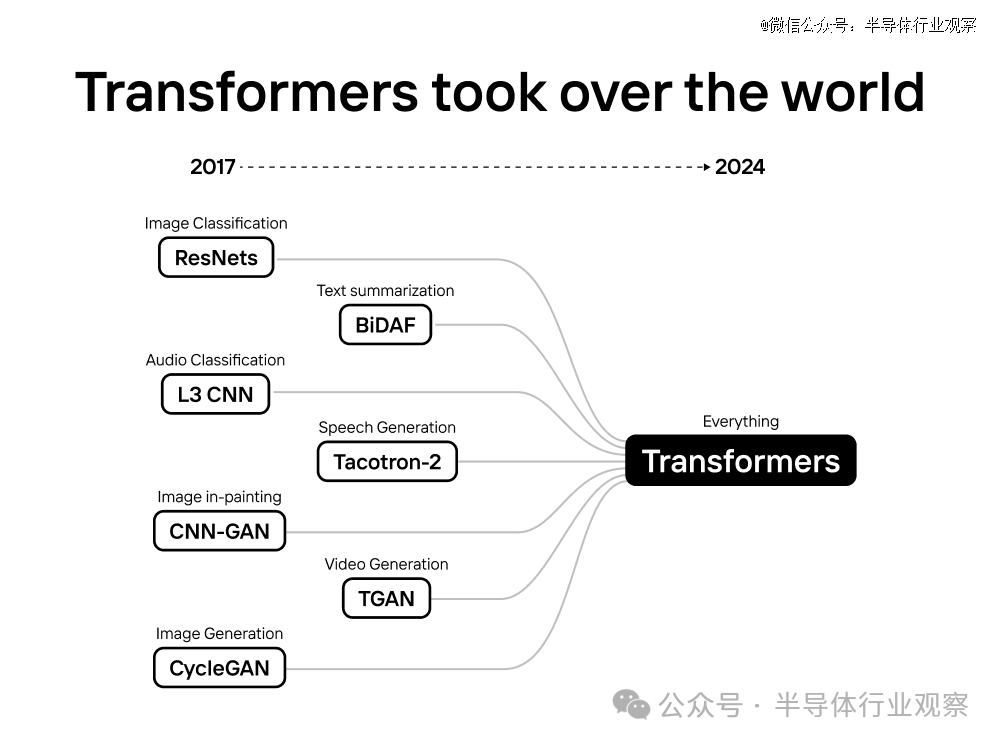

在 transformer 统治世界之前,许多公司都构建了灵活的 AI 芯片和 GPU 来处理数百种不同的架构。以下列举一些:

NVIDIA的GPUs、Google的TPUs、Amazon的Trainium、AMD的加速器、Graphcore的IPUs、SambaNova SN Series、Cerebras的CS-2、Groq的GroqNode、Tenstorrent的Grayskull、D-Matrix的Corsair、Cambricon的Siyuan和Intel的Gaudi.

从来没有人制造过专门针对算法的 AI 芯片 (ASIC)。芯片项目的成本为 5000 万至 1 亿美元,需要数年时间才能投入生产。我们刚开始时,没有市场。

突然间,情况发生了变化:

前所未有的需求:在 ChatGPT 之前,Transformer 推理的市场约为 5000 万美元,现在则达到数十亿美元。所有大型科技公司都使用 Transformer 模型(OpenAI、谷歌、亚马逊、微软、Facebook 等)。

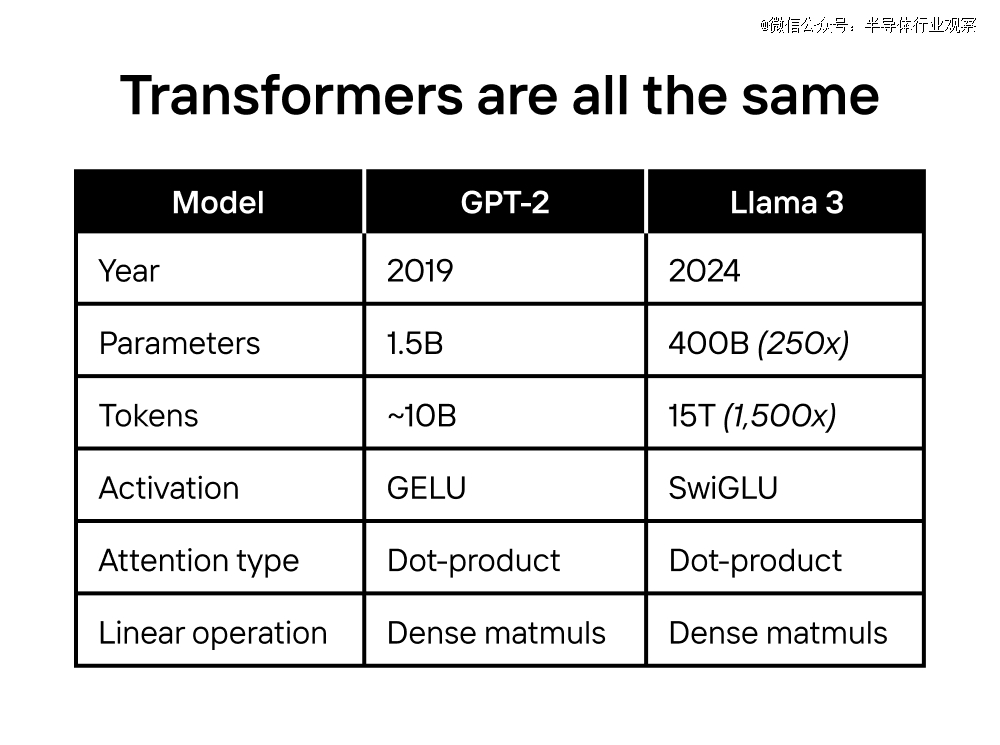

架构上的融合:AI 模型过去变化很大。但自 GPT-2 以来,*进的模型架构几乎保持不变!OpenAI 的 GPT 系列、谷歌的 PaLM、Facebook 的 LLaMa,甚至 Tesla FSD 都是 Transformer。

当模型的训练成本超过 10 亿美元,推理成本超过 100 亿美元时,专用芯片是不可避免的。在这个规模下,1% 的改进将证明 5000 万至 1 亿美元的定制芯片项目是合理的。

事实上,ASIC 的速度比 GPU 快几个数量级。当比特币矿机于 2014 年进入市场时,丢弃 GPU 比使用它们来挖掘比特币更便宜。

由于涉及数十亿美元的资金,人工智能也将发生同样的情况。

Transformer 惊人地相似:诸如 SwiGLU 激活和 RoPE 编码之类的调整随处可见:LLM、嵌入模型、图像修复和视频生成。

虽然 GPT-2 和 Llama-3 是相隔五年的*进的 (SoTA) 模型,但它们的架构几乎相同。*的主要区别是规模。

Etched相信硬件彩票(hardware lottery):获胜的模型是那些可以在硬件上运行速度最快、成本*的模型。Transformer 功能强大、实用且利润丰厚,足以在替代品出现之前主宰每个主要的 AI 计算市场:

Transformer 为每一种大型 AI 产品提供动力:从代理到搜索再到聊天。AI 实验室已花费数亿美元进行研发,以优化 GPU 以适应 Transformer。当前和下一代*进的模型都是 Transformer。

随着模型在未来几年从 10 亿美元扩展到 100 亿美元再到 1000 亿美元的训练运行,测试新架构的风险飙升。与其重新测试缩放定律和性能,不如花时间在 Transformer 之上构建功能,例如多token预测。

当今的软件堆栈针对 Transformer 进行了优化。每个流行的库(TensorRT-LLM、vLLM、Huggingface TGI 等)都有用于在 GPU 上运行 Transformer 模型的特殊内核。许多基于 transformer 构建的功能在替代方案中都不容易获得支持(例如推测解码、树搜索)。

未来的硬件堆栈将针对 transformer 进行优化。NVIDIA 的 GB200 特别支持 transformer(TransformerEngine)。像 Sohu 这样的 ASIC 进入市场标志着不归路。Transformer 杀手在 GPU 上的运行速度需要比 transformer 在 Sohu 上运行的速度更快。如果发生这种情况,我们也会为此构建一个 ASIC!

两个哈佛辍学生创立芯片公司

随着生成式人工智能触及越来越多的行业,生产运行这些模型的芯片的公司受益匪浅。尤其是英伟达,其影响力巨大,占据了人工智能芯片市场约70% 至 95% 的份额。从Meta到微软,云提供商都在英伟达 GPU 上投入了数十亿美元,担心在生成式人工智能竞赛中落后。

因此,生成式人工智能供应商对现状不满也是可以理解的。他们的成功很大程度上取决于主流芯片制造商的意愿。因此,他们与机会主义风险投资公司一起,正在寻找有前途的新兴企业来挑战人工智能芯片巨头。

Etched是众多争夺一席之地的另类芯片公司之一,但它也是最有趣的公司之一。Etched 成立仅两年,由两位哈佛辍学生 Gavin Uberti(前OctoML和前Xnor.ai员工)和 Chris Zhu 创立,他们与 Robert Wachen 和前赛普拉斯半导体公司首席技术官 Mark Ross 一起,试图创造一种可以做一件事的芯片:运行 AI 模型。

这并不罕见,许多初创公司和科技巨头都在开发专门运行人工智能模型的芯片,也称为推理芯片。Meta 有MTIA,亚马逊有Graviton和Inferentia等等。但 Etched 的芯片的独特之处在于它们只运行一种类型的模型:Transformers。

Transformer 由谷歌研究团队于 2017 年提出,目前已成为主流的生成式 AI 模型架构。

Transformer 是 OpenAI 视频生成模型Sora的基础。它们是 Anthropic 的Claude和谷歌的Gemini等文本生成模型的核心。它们还为最新版本的 Stable Diffusion等艺术生成器提供动力。

在一篇新博客文章中,Etched创始人表示,该公司在 2022 年 6 月对人工智能进行了*的押注,当时它押注一种新的人工智能模型将接管世界:Transformer。

在Etched看来,五年内,AI 模型在大多数标准化测试中都比人类更聪明。

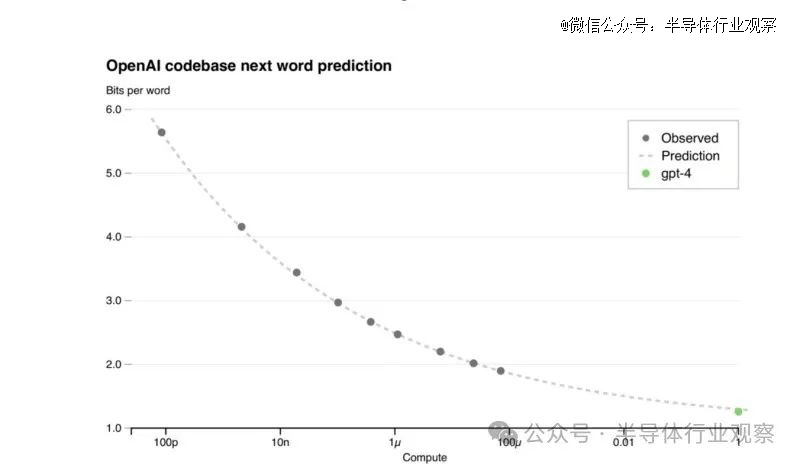

怎么会这样?因为 Meta 训练 Llama 400B(2024 SoTA,比大多数人类更聪明)所用的计算量是 OpenAI 在 GPT-2(2019 SoTA)上所用的 50,000 倍。

通过为 AI 模型提供更多计算和更好的数据,它们会变得更聪明。规模是几十年来*持续有效的秘诀,每家大型 AI 公司(谷歌、OpenAI / 微软、Anthropic / 亚马逊等)都将在未来几年投入超过 1000 亿美元来保持规模。我们正处于有史以来*的基础设施建设中。

但再扩大 1,000 倍将非常昂贵。下一代数据中心的成本将超过一个小国的 GDP。按照目前的速度,我们的硬件、电网和钱包都跟不上。

我们并不担心数据耗尽。无论是通过合成数据、注释管道还是新的 AI 标记数据源,我们都认为数据问题实际上是推理计算问题。Mark Zuckerberg4、Dario Amodei5 和 Demis Hassabis6似乎同意这一观点。

“2022 年,我们打赌Transformer将统治世界,”Etched 首席执行官 Uberti 在接受 TechCrunch 采访时表示。“在人工智能的发展中,我们已经达到了一个节点,性能优于通用 GPU 的专用芯片是不可避免的——全世界的技术决策者都知道这一点。”

当时,AI 模型种类繁多,有用于自动驾驶汽车的 CNN、用于语言的 RNN 以及用于生成图像和视频的 U-Net。然而,Transformer(ChatGPT 中的“T”)是*个可以扩展的模型。

首席执行官 Gavin Uberti 在博文中表示:“我们打赌,如果智能随着计算不断扩展,几年之内,公司将在 AI 模型上投入数十亿美元,所有模型都在专用芯片上运行。”“我们花了两年时间打造了世界上*款Transformer专用芯片 (ASIC) Sohu。我们将Transformer架构刻录到我们的芯片中,我们无法运行传统的 AI 模型:为您的 Instagram 提要提供支持的 DLRM、来自生物实验室的蛋白质折叠模型或数据科学中的线性回归。”

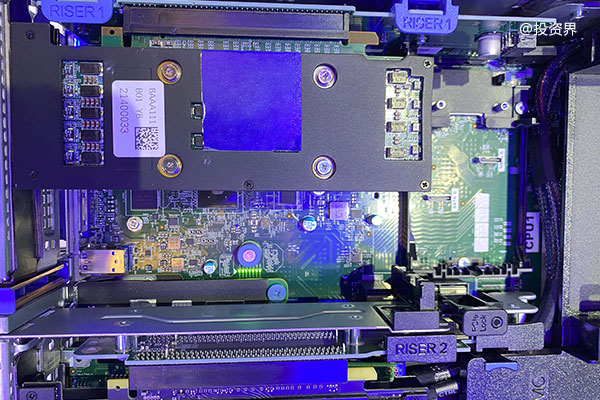

一颗名为“sohu”的4nm芯片

Etched 的芯片名为 Sohu,是一款 ASIC(专用集成电路)。Uberti 声称,Sohu 采用台积电的 4nm 工艺制造,可以提供比 GPU 和其他通用 AI 芯片更好的推理性能,同时消耗更少的能源。

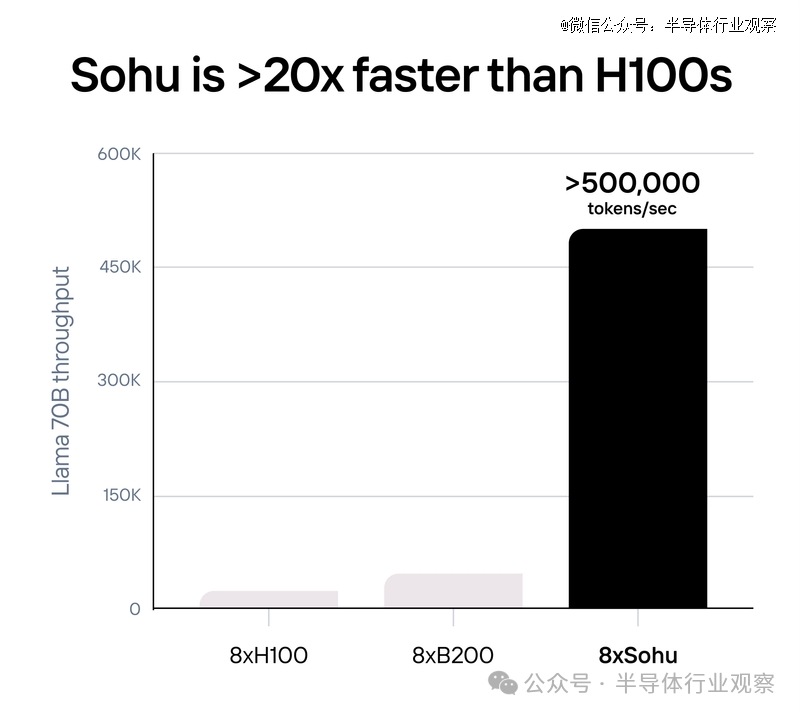

Uberti 表示:“在运行文本、图像和视频转换器时,Sohu 的速度甚至比 Nvidia 的下一代 Blackwell GB200 GPU 快一个数量级,而且成本更低。一台 Sohu 服务器可取代 160 个 H100 GPU。……对于需要专用芯片的企业*来说,Sohu 将是一个更经济、更高效、更环保的选择。”

Uberti 补充道:“我们也无法运行 CNN、RNN 或 LSTM。但对于 transformer 来说,Sohu 是有史以来最快的芯片。它甚至没有竞争对手。Sohu 的速度甚至比 Nvidia 的下一代 Blackwell (GB200) GPU 快一个数量级,而且更便宜,适用于文本、音频、图像和视频 transformer。”

Uberti表示,自他们成立以来,每个主要的 AI 模型(ChatGPT、Sora、Gemini、Stable Diffusion 3、Tesla FSD 等)都变成了 transformer。不过,如果 transformer 突然被 SSM、monarch 混合器或任何其他类型的架构取代,Etched 的芯片将毫无用处。

“但如果我们是对的,Sohu将改变世界,”Uber信心满满地说。

通过专业化,Sohu获得了前所未有的性能。一台 8xSohu 服务器每秒可以处理超过 500,000 个 Llama 70B token。

据介绍,Sohu 仅支持转换器推理,无论是 Llama 还是 Stable Diffusion 3。Sohu 支持当今的所有模型(Google、Meta、Microsoft、OpenAI、Anthropic 等),并且可以处理对未来模型的调整。

由于 Sohu 只能运行一种算法,因此可以删除绝大多数控制流逻辑,从而允许它拥有更多的数学块。因此,Sohu 拥有超过 90% 的 FLOPS 利用率(而使用 TRT-LLM 的 GPU7 上约为 30%)。

强悍性能,如何做到?

Sohu是如何实现这一切的?有几种方法,但最明显(也是最直观)的方法是简化推理硬件和软件管道。由于Sohu不运行非transformer模型,因此 Etched 团队可以取消与transformer无关的硬件组件,并削减传统上用于部署和运行非transformer的软件开销。

Etched在一篇博客文章中表示,NVIDIA H200 拥有 989 TFLOPS 没有稀疏性的 FP16/BF16 计算能力。这是*进的(甚至比谷歌的新 Trillium 芯片还要好),而 2025 年推出的 GB200 的计算能力仅增加了 25%(每个die 1250 TFLOPS)。

由于 GPU 的绝大部分区域都用于可编程性,因此专注于transformer可以让您进行更多的计算。您可以从*原理向自己证明这一点:

构建单个 FP16/BF16/FP8 乘加电路需要 10,000 个晶体管,这是所有矩阵数学的基石。H100 SXM 有 528 个张量核心,每个都有 4 × 8 × 16 FMA 电路。乘法告诉我们 H100 有 27 亿个专用于张量核心的晶体管。

但 H100 有 800 亿个晶体管12!这意味着 H100 GPU 上只有 3.3% 的晶体管用于矩阵乘法!

这是 NVIDIA 和其他灵活 AI 芯片经过深思熟虑的设计决定。如果您想支持各种模型(CNN、LSTM、SSM 等),没有比这更好的了。

通过仅运行 Transformer,Etched可以在芯片上安装更多的 FLOPS,而无需降低精度或稀疏性。

有观点认为,推理的瓶颈是内存带宽,而不是计算?事实上,对于像 Llama-3 这样的现代模型来说,答案是显而易见的!

让我们使用 NVIDIA 和 AMD 的标准基准 :2048 个输入tokens和 128 个输出tokens。大多数 AI 产品的prompts 比completions时间长得多(即使是新的 Claude 聊天在系统提示中也有 1,000 多个tokens)。

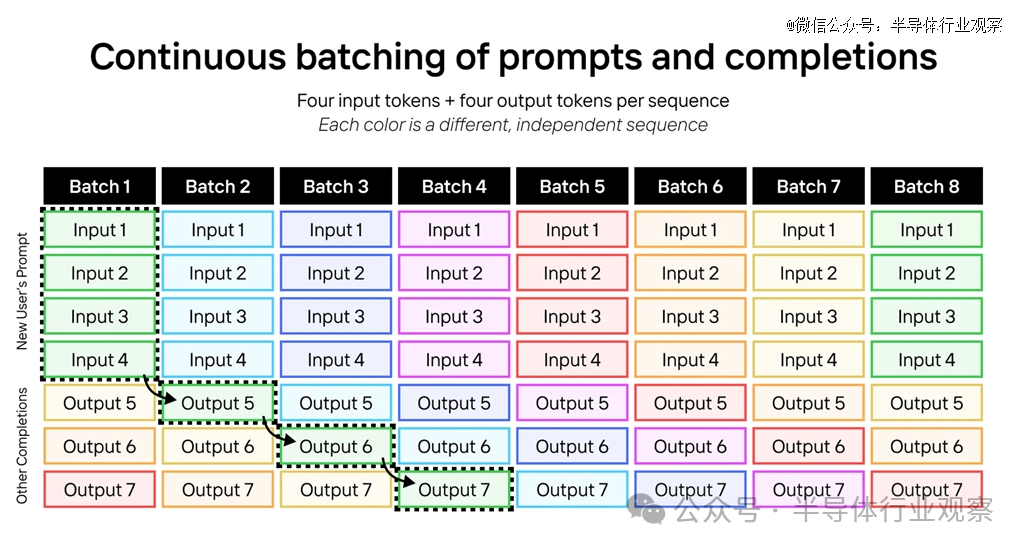

在 GPU 和Sohu上,推理是分批(batches)运行的。每个批次都会加载所有模型权重一次,并在批次中的每个标记中重复使用它们。通常,LLM 输入是计算密集型的,而 LLM 输出是内存密集型的。当我们将输入和输出token与连续批处理相结合时,工作负载会变得非常受计算密集型。

下面是 LLM 连续批处理的一个例子。在这里,我们正在运行具有四个输入标记和四个输出标记的序列;每种颜色都是不同的序列。

我们可以扩展相同的技巧来运行具有 2048 个输入token和 128 个输出token的 Llama-3-70B。让每个批次包含一个序列的 2048 个输入token和 127 个不同序列的 127 个输出tome。

如果我们这样做,每个批次将需要大约 (2048 + 127) × 70B 参数 × 每个参数 2 字节 = 304 TFLOP,而只需加载 70B 参数 × 每个参数 2 字节 = 140 GB 的模型权重和大约 127 × 64 × 8 × 128 × (2048 + 127) × 2 × 2 = 72GB 的 KV 缓存权重。这比内存带宽要多得多:H200 需要 6.8 PFLOPS 的计算才能*限度地利用其内存带宽。这是利用率为 100% 的情况 - 如果利用率为 30%,则需要 3 倍以上的内存。

由于Sohu拥有如此多的计算能力和极高的利用率,我们可以运行巨大的吞吐量,而不会出现内存带宽瓶颈。

而在现实世界中,批次要大得多,输入长度各不相同,请求以泊松分布(Poisson distribution)到达。这种技术在这些情况下效果更好,但我们在此示例中使用 2048/128 基准,因为 NVIDIA 和 AMD 使用它。

众所周知,在 GPU 和 TPU 上,软件是一场噩梦。处理任意 CUDA 和 PyTorch 代码需要非常复杂的编译器。第三方 AI 芯片(AMD、Intel、AWS 等)在软件上花费了数十亿美元,但收效甚微。

但由于Sohu只运行 transformer,我们只需要为 transformer 编写软件!

大多数运行开源或内部模型的公司都使用特定于 transformer 的推理库,如 TensorRT-LLM、vLLM 或 HuggingFace 的 TGI。这些框架非常僵化 - 虽然你可以调整模型超参数,但实际上不支持更改底层模型代码。但这没关系 - 因为所有 transformer 模型都非常相似(甚至是文本/图像/视频模型),调整超参数就是你真正需要的。

虽然这支持 95% 的 AI 公司,但*的 AI 实验室采用定制。他们有工程师团队手动调整 GPU 内核以挤出稍微更多的利用率,逆向工程哪些寄存器对每个张量核心的延迟*。

有了 Etched,您无需再进行逆向工程 - 因为Etched的软件(从驱动程序到内核再到服务堆栈)都将是开源的。如果您想实现自定义转换层,您的内核向导可以自由地这样做。

Etched将成为全球*

Uberti说,每一个大型同质计算市场最终都会以专用芯片结束:网络、比特币挖掘、高频交易算法都被硬编码到硅片中。

这些芯片的速度比 GPU 快几个数量级。没有一家公司使用 GPU 来挖掘比特币——他们根本无法与专业的比特币矿工竞争。人工智能也会发生这种情况。Uberti 说,由于涉及数万亿美元,专用是不可避免的。

“我们认为,绝大部分支出(和价值)将用于具有超过 10 万亿个参数的模型。由于连续批处理的经济性,这些模型将在数十个 MegaClusters 之一的云端运行,”Uberti 说。“这种趋势将反映芯片工厂:过去有数百个廉价的低分辨率工厂,而现在,高分辨率工厂的建设成本约为 200 亿至 400 亿美元。世界上只有少数几个 MegaFab,它们都使用非常相似的底层架构(EUV、858 平方毫米掩模版、300 毫米晶圆等)。”

Etched 表示,Transformer 的转换成本非常高。即使发明了一种比 Transformer 更好的新架构,重写内核、重建推测解码等功能、构建新的专用硬件、重新测试缩放定律以及重新培训团队的阻力也是巨大的。Uberti 表示,这种情况十年内只会发生一两次,就像芯片领域发生的情况一样:光刻技术、掩模版/晶圆尺寸和光刻胶成分的变化确实会继续发生,但变化速度非常缓慢。

“我们扩展 AI 模型的程度越高,我们就越会集中于模型架构。创新将发生在其他地方:推测解码、树搜索和新的采样算法,”Uberti 说。“在一个模型训练成本为 100 亿美元、芯片制造成本为 5000 万美元的世界里,专用芯片是不可避免的。*制造它们的公司将获胜。”

Etched 断言,从来没有人制造过特定架构的 AI 芯片。即使在去年,这也毫无意义。特定架构的芯片需要巨大的需求和对其持久力的坚定信念。

Uberti表示:“我们把赌注押在了Transformer 上,这两个要求都正在成为现实。”

该公司指出,市场需求已达到前所未有的水平。Transformer 推理市场刚开始时不到 5000 万美元,而现在已超过 50 亿美元。所有大型科技公司都在使用 Transformer 模型(OpenAI、谷歌、亚马逊、微软、Facebook 等)。

Uberti 表示,他们正在看到架构融合:过去,AI 模型会发生很大变化。但自 GPT-2 以来,*进的模型架构几乎保持不变。OpenAI 的 GPT 系列、Google 的 PaLM、Facebook 的 LLaMa,甚至 Tesla FSD 都是Transformer 。

Uberti 表示,公司正以极快的速度努力将Sohu变成现实。

Uberti 强调:“公司正朝着有史以来最快的速度推进,从架构到验证硅片,以用于 4nm 光罩大小的芯片。”“我们直接与台积电合作,并从两家*供应商处双源采购 HBM3E。我们从 AI 和基础模型公司获得了数千万美元的预订,并且拥有充足的供应链能力来扩展。如果我们的赌注正确并且我们执行,Etched 将成为世界上*的公司之一。”

该公司重申,如果这一预测正确,Sohu将改变世界。

如今,AI 编码代理的计算成本为 60 美元/小时,并且需要数小时才能完成任务,Gemini 需要 60 多秒才能回答有关视频的问题16。编码代理的成本高于软件工程师,并且需要数小时才能完成任务。视频模型每秒生成一帧,甚至当 ChatGPT 注册用户达到 1000 万时(仅占全球的 0.15%),OpenAI 也耗尽了 GPU 容量。

我们无法解决这个问题 - 即使我们继续以每两年 2.5 倍的速度制造更大的 GPU,也需要十年才能实现实时视频生成。

你设想一下,如果人工智能模型一夜之间速度提高 20 倍且成本降低,会发生什么?有了Sohu,实时视频、音频、代理和搜索终于成为可能。Uberti 表示,每款 AI 产品的单位经济效益将在一夜之间发生逆转。

据透露,该公司的早期客户已经预订了数千万美元的硬件。

在被问到 Etched 这样的小公司如何能击败 Nvidia。Etched 首席运营官联合创始人 Robert Wachen 在给 VentureBeat 的电子邮件中说:

“过去,AI 计算市场是分散的:人们使用不同类型的模型,例如 CNN、DLRM、LSTM、RNN 以及跨领域的数十种其他模型。每种架构的支出都在数千万到数亿美元之间,而这些工作负载的市场足够大,通用芯片 (GPU) 可以胜出,”Wachen 说道。

他指出,市场正在迅速整合为一种架构:Transformer。在人们花费数十亿美元购买变压器模型、定制芯片花费 5000 万至 1 亿美元的世界里,专用芯片是不可避免的。

“我们的芯片在大多数工作负载下都无法击败 GPU——我们无法支持它们。但是,对于变压器推理(为每种主要的“生成式 AI”产品提供支持),我们将清除市场。通过如此专业化,我们的芯片比下一代 Blackwell GPU 快一个数量级,”Wachen 说道。

参考链接

https://venturebeat.com/ai/etched-raises-120m-in-challenge-to-nvidia-in-ai-with-transformer-chips/

https://www.etched.com/announcing-etched

https://techcrunch.com/2024/06/25/etched-is-building-an-ai-chip-that-only-runs-transformer-models/

【本文由投资界合作伙伴微信公众号:半导体行业观察授权发布,本平台仅提供信息存储服务。】如有任何疑问,请联系(editor@zero2ipo.com.cn)投资界处理。