由互联网和科技界掀起的大模型浪潮,迎来了新战事。

自今年3月以来,国内已有超过20家企业入局大模型赛道。从百度“文心一言”、阿里“通义千问”的发布,到360“红孩儿”、商汤“日日新”、网易“玉言”、科大讯飞“星火”、昆仑万维“天工”等的推出,再到腾讯“混元”、京东“ChatJ”、华为“盘古”等的预告。互联网巨头、科技公司纷纷秀出“肌肉”,谁也不想在这场大模型混战中掉队。

而在这场狂奔中,大模型的发展阶段已经从“通用”迈入“垂类”。

算力、大规模数据、高成本人才成为大部分企业入局通用大模型的拦路虎。但深度定制、广阔的场景应用等诉求,催生了国内垂直领域大模型的开发。

近两个月来,不少医疗、金融、教育、绘画等行业内拥有用户数据积累的中小型企业,已开始基于国内外大模型“底座”,训练适配自身的垂类模型。同时,已发布通用大模型的公司,也推出了针对特有行业的模型。

如果说通用大模型是大模型发展的初期阶段,那么垂直场景应用则可以视作其“中场战事”,在该阶段,应用与场景先行,倒逼垂直领域的大模型飞跃发展,并率先在不同产业中实现了落地价值。

路线分化

短短两个月,分化已经出现。

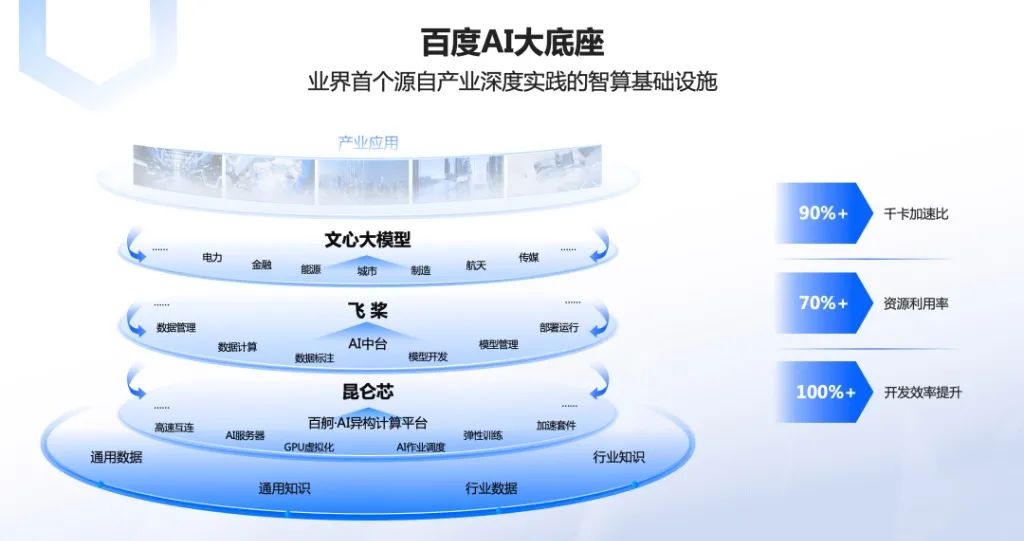

在5月23日举办的文心大模型技术交流会上,百度智能云AI与大数据平台总经理忻舟介绍:“文心千帆大模型平台,是百度提供给客户的企业级大模型生产平台,不但提供包括文心一言在内的大模型服务及第三方大模型服务,还提供大模型开发和应用的整套工具链。”

即文心千帆可以文心一言为核心,提供大模型服务,帮助客户改造产品和生产流程;企业也可以在文心千帆上基于任何开源或闭源的大模型,开发自己的专属大模型。

多位接受全天候科技采访的业内人士认为,当前国内大模型赛道主要包括三类:一类对标GPT的通用大模型,聚焦基础层的公司;一类是在开源大模型基础之上训练垂类大模型,聚焦垂直行业的企业;另一类则是专注具体应用的纯应用公司。

“刚开始大家是一窝蜂扎进通用大模型,现在分化已经出现,不管是分化到具体行业的,还是不做研发直接调用接口做产品运营的,这个趋势是越来越清晰了。”前金山软件副总裁兼人工智能事业部负责人、现AI领域创业者李长亮告诉全天候科技。

通用大模型面临算力需求大、训练和推理成本高、数据质量不佳等挑战。一个成功的且可对外商业化输出的通用大模型大模型,要求厂商拥有全栈大模型训练与研发能力、业务场景落地经验、AI安全治理举措、以及生态开放性等核心优势。

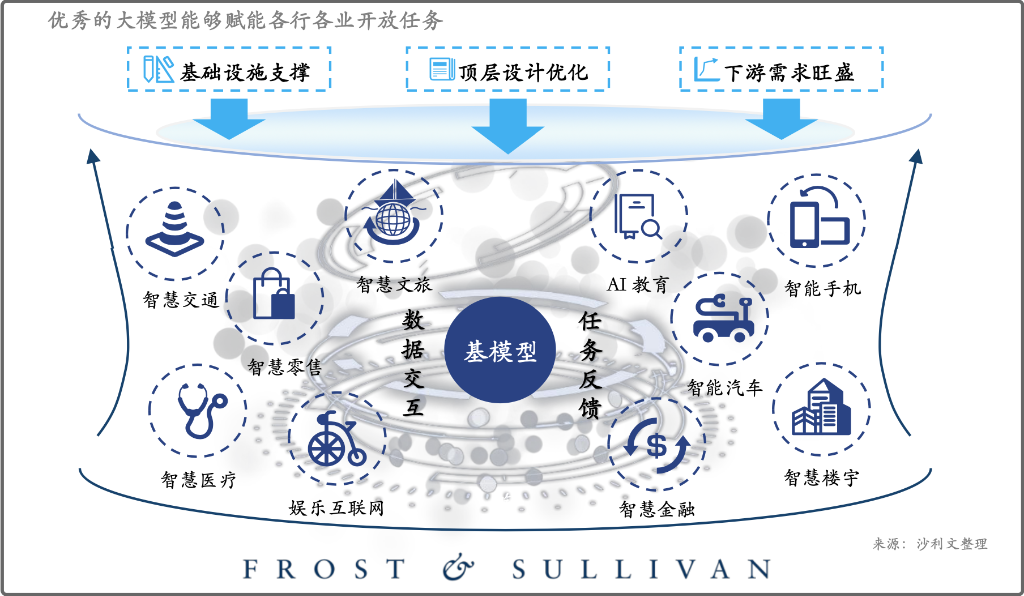

在百度智能云副总裁朱勇看来,基础模型(通用大模型)的公司可能“只有那么几家”,但是上面会长出很多专业领域的大模型。

“训练一个基础模型,成本是非常高的,做一个千亿级的大模型,需要单机群万卡以上的算力。”朱勇说,从国内外来看,真正做通用模型的公司并没有那么多。相反,训练领域(垂类)模型所需要的代价和资源远远小于从零开始做通用模型。

因而,从商业逻辑的角度来看,大部分公司不具备做通用大模型的能力,巨头更适合做通用大模型,拥有丰富场景数据积累的公司更适合做垂域模型。

垂类大模型以深度解决行业需求为主,即企业在自己擅长的领域训练适合自己的“产业版GPT”。这类大模型生成的内容更符合特定垂类场景的需求,质量更高。

当前,已经可以看到不少垂类模型应用在金融、医疗、交易等场景中。比如,彭博社根据自身丰富的金融数据资源,基于GPT-3框架再训练,开发出了金融专属大模型BloombergGPT。

除了上述两种常见的模式,目前国内大模型创业赛道上还有一种专做应用的公司,它们没有研发团队,从现有大模型调用接口,做产品和运营。

通用VS 垂域

布局通用大模型的巨头,需要的是生态。所以百度、阿里都希望成为“大模型的底座”去赋能行业与企业。但并不是所有企业都有这样的能力。

“现有大模型的算力和能耗挑战会促使很多工作向领域专用化、轻量化的大模型方向发展,特别是金融、教育、医疗、交通等领域,大量的工作在试图降低大模型的成本。”在日前举行的第六届数字中国建设峰会上,中国科学院自动化研究所副所长曾大军表示。

相比通用大模型需要高昂的开发训练成本,基于开源模型进行垂类模型开发可兼顾开发成本和数据安全。

事实上,挑战之外,实际的场景需求也加快了大模型垂类化的过程。

“中国擅长商业模式、应用上的创新。”一位AI领域创业者说,与此同时,国内不乏AI模型的落地场景、丰富的数据,以及追风口的热情。因而,短短两个月时间,大模型领域化的发展飞速。

以百度文心千帆这个“AI大模型底座”为例,当前正在共同测试研发的企业通常来自信息化和技术普及率较高的行业,如金融行业、能源行业、泛互联网行业等。

“垂类模型是在通用大模型基础上训练的,撇开通用大模型的话,是不存在垂类模型的。”忻舟说,垂类模型强调领域的know-how,对于特定领域来说,需要针对该领域的任务做指令学习。

行业不同,场景不同,指令学习的区别也极大。比如,泛互联网行业更关注营销、推荐的效果,金融更领域更关注风控、可信、以及营销的效果。

在李长亮看来,垂类大模型与通用大模型*的区别在于:垂类大模型在资源投入、成本投入等方面的要求下降了,但额外要求是行业known-how,即对这个行业的knowledge要求提高了。

表现在数据方面,在特定的垂直领域,企业拥有私有数据,这是别的企业花钱也买不到的核心竞争力和天然优势。

表现在算力上,通过通用大模型微调实现的垂类大模型相较通用大模型是“几何级别的下降”。

根据国金证券的测算,在模型微调阶段,由于训练量级较小,仅为万级,相关的算力成本相比之下可忽略不计。

以斯坦福大学于2023年3月发布Alpaca为例,这是一个基于LLaMA-7B基座,应用5.2万指令对模型微调训练而来的对话类语言模型。该模型基于8块A100微调,微调时长3小时,算力成本不超过300元。

当然,并不是所有企业都可以在通用大模型的基础上做微调。

以百度文心千帆为例,要在该平台上通过微调做自己的大模型需具备两个条件:企业有没有高质量的数据存下来;能否将自身业务根据对生成式AI的理解变成高质量的数据,变成指定数据做指定微调。

换言之,落地在企业端,那些有海量行业数据、懂行业know-how的企业,做成垂类模型的机会更大。

“因为有专业的数据、有行业know-how,结合不同类型的领域模型,这些领域模型将来会非常繁荣,支撑上层非常繁荣的领域应用。”朱勇说。

“两条腿”走路

“GPT+行业专家系统”的模式产生了新的垂直领域大模型。

大模型*的价值在于革新商业模式,改造商业组织的每一个环节,进而起到降本增效的效果。这也是企业纷纷入局大模型的原因所在。

而Meta旗下LLaMA模型等大模型的开源为垂类模型的发展装上了加速器。

公开信息显示,LLaMA基于通用领域的开源数据集进行训练,训练数据涵盖40种语言,包含约1.4万亿Tokens。LLaMA模型一经发布就对外完全开源,吸引了广大AI开发者。

作为完全开源的*模型,LLaMA具备高度的灵活性、可配置性和泛化能力,可以作为垂类AI模型的通用基座。

尽管LLaMA模型参数量较小,但性能丝毫不逊色于PaLM、GPT-3等大语言模型。并且较小的参数规模显著降低了LLaMA模型的落地部署和二次开发难度。

“基于LLaMA这种开源模型,我们喂自己的数据,慢慢调试,就能调试出我想要的效果来。”一位AIGC领域的创业者告诉全天候科技。

全天候科技了解到,当下不少企业采用的是“两条腿走路”的策略,即:一边接入大模型API,一边在开源模型上炼模型,两者构成反馈链,加速各自能力的提升,打造创新闭环。

“调用API接口也是一个获取数据资源的有效手段。”李长亮说,这部分数据将来可能在企业训练模型的时候起作用。

在不少业内人士看来,对于各行各业来说,垂直大模型是一种全新的生产力,各个行业的垂直领域大模型对所在行业可能产生重大甚至是颠覆性的影响。

值得一提的是,在一级市场上,专注于垂类大模型的创业公司也是投资机构眼中的“宝藏”。

在不久前召开的2023中国投资年会上,天堂硅谷高级合伙人王伟将“垂直领域大模型,掌握行业数据、懂行业Know-how的项目”列为其重点投资布局的领域之一。

【本文由投资界合作伙伴微信公众号:全天候科技授权发布,本平台仅提供信息存储服务。】如有任何疑问,请联系(editor@zero2ipo.com.cn)投资界处理。