抛弃Transformer,谷歌八子最后一位作者创业

上个月刚宣布离职谷歌的Transformer论文作者“Llion Jones”,最新动向尘埃落定。

据金融时报消息,Llion Jones将和前谷歌大脑*研究人员David Ha,共同在东京创办人工智能研究公司Sakana AI。据透露公司将聚焦做生成式大模型,创建一种基于“自然启发的新型智能基础模型”。

消息一出,圈内著名话唠、英伟达科学家Jim Fan也*时间发来贺电。

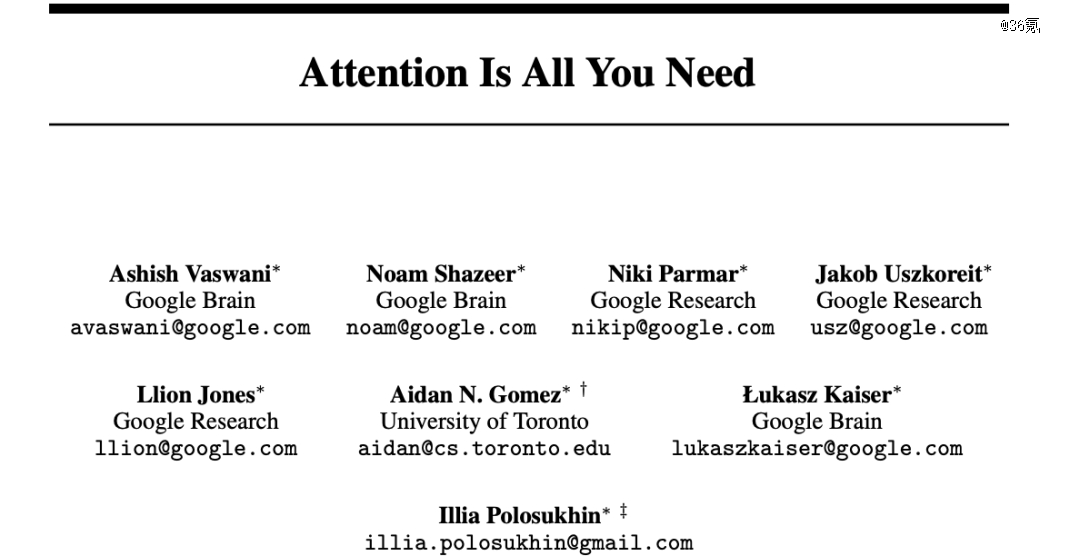

Llion Jones作为前谷歌科学家,他与其他七名作者一起发表的论文《Attention is All You Need》如今已经成为大部分大模型的“奠基研究”,引用次数更是高达8w+。目前OpenAI的GPT模型、谷歌的Bard模型均以Transformer架构进行设计。

另一位创始人David Ha,则拥有“谷歌日本人工智能研究部前负责人”和“Stability AI前研究主管”双重身份。

Llion Jones(左)David Ha(右)

大模型领域火热有目共睹,除去像Google、Microsoft、Meta、OpenAI等不差钱的巨头玩家,还有包括Cohere、Personter.AI、Anthropic等在内的众多初创公司。

在外界看来,Sakana AI的大模型选择以Transformer为架构也是顺理成章的事,但这次两人打算摒弃Transformer,玩点不一样的。

在采访中,Jones和Ha指出,当前AI大模型的建构就像工程学,神经网络就像一座桥,它们被设计成脆弱且不可改变的结构。

比如,像GPT这类大模型虽能力极强,但也很容易被黑客操纵生成有害或危险的内容,就像手机越狱一样。而以目前的技术,想要避免这种情况的发生,就需要开发者手动更新模型参数。

简单来说,因为模型框架被设计的非常严格,创新也变得很困难。

相比之下,自然系统中的集体智能则更敏感响应环境变化。因此,两人希望能利用演化计算的原理来构建人工智能模型,使其像自然系统一样可适应变化、节省成本并提高安全性。

具体来说,就是通过制造多个较小的人工智能模型,每个模型都有自己独特的优势和较小的数据集,让他们像鱼群一样协同起来,共同解决一个问题。

这个理念也反应在公司名字上,Sakana来源于日语中鱼的一个单词“さ yl”(sa-ka-na),意在“将一群鱼聚集在一起,用简单的规则组成一个连贯的实体”的想法,类似于自然界中的进化论、集体智慧等概念 。

在公司官网logo设计上,可以看到一群鱼在游走,其中竞争对手就像一只只黑色的鱼,依循同一方向,而Sakana是那只红色的鱼,朝向另一个截然不同的方向,也代表着两人创立公司的初衷就是想玩点新的。

根据官网介绍,这种新型AI模型主要以两种形式落地。一方面像大模型用于生成文本、图像、代码等多个模态的内容。另一方面也能给ChatGPT这样产品提供支持、协同更多大模型产品工作,实现能力上的“无缝衔接”。

事实上,这一次的另辟蹊径也并非突然奇想。创始人之一David Ha在过去一段时间已发布多篇关于“深度学习出现集体智慧创意研究”的论文和博客。

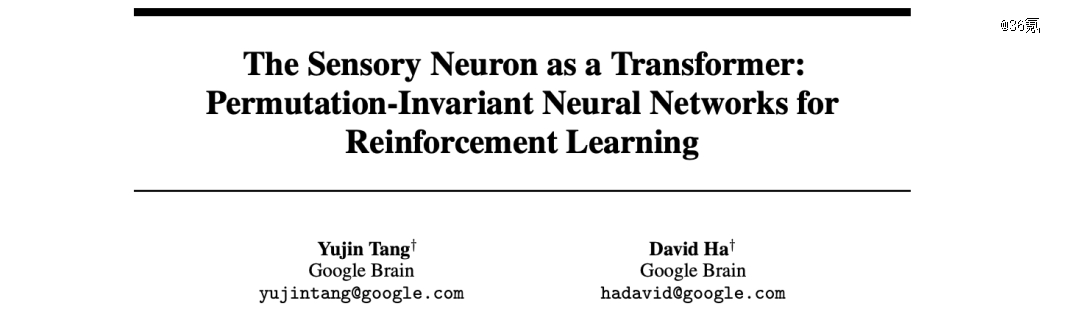

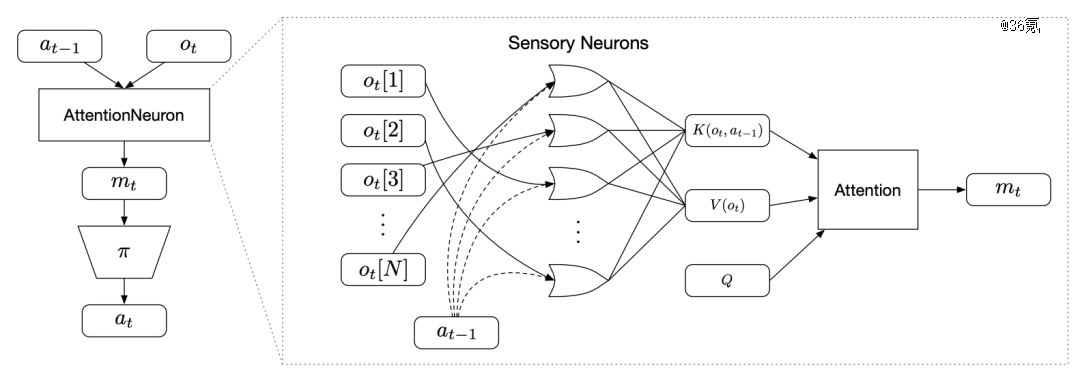

比如,他在2021年发表的论文《The Sensory Neuron as a Transformer: Permutation-Invariant Neural Networks for Reinforcement Learning》中提出一种AttentionNeuron的网络层,可以将每个输入通道连接到一个独立的神经网络模块,每个模块只处理各自的局部输入,然后通过注意力机制交流信息。

论文中,研究人员将一个完整的图像进行打乱切块,然后输入到多个局部神经网络模块中,每个模块只看到一小块图像,然后通过注意力机制整合所有模块的输出。

实验表明,在自动驾驶CarRacing环境中,即使输入的图像块已被随机打乱顺序,AttentionNeuron在没学习过环境内容的情况下,也可以实现一定程度上的自动驾驶,表现出更好的鲁棒性和泛化能力。

最近,David Ha还与DeepMind科学家Yujin Tang合著了一篇论文《Collective Intelligence for Deep Learning: A Survey of Recent Developments》,系统探讨了机器学习中越来越受欢迎的基于复杂系统的想法,例如群体智能、自组织、紧急行为等。

除此以外,对于为何没有把公司设立在火热的硅谷,两人也有自己的想法。

Jones表示,谷歌和其他公司现在都把大量精力放在技术商业化层面,这意味着进行前沿研究的空间会越来越小。创立Sakana的主要目标是想专注做研究,选择东京一方面可以避免受到“硅谷炒作AI”的影响,另一方面也有当地政策惠顾的原因。

总结一句话就是:不搞炒作,专心做LLM研究。

截至目前,两人并未透露过多关于融资的消息,仅表示会考虑这方面。

不过,Transformer论文的八位作者出走之后,不少人都选择了创业,成为这波生成式AI浪潮中的重要创业力量,估值也水涨船高。

此前,Transformer八位作者之一“Noam Shazeer”创立的Character.AI,在今年三月完成1.5亿美元A轮融资,仅用16个月时间就成为一家独角兽公司。

另外一名作者Aidan Gomez,他在2019年创办的Cohere,分别于2021年9月和2022年2月先后获得总计2亿多美元融资,投资者不乏图灵奖获得者Geoffrey Hinton、知名人工智能研究员李飞飞、UC伯克利大牛Pieter Abbeel等大牛。

今年6月,Cohere更是拿到了由英伟达等参投的2.5 亿美元融资,当前估值已达20亿美元。

参考这些Transformer协作者创业伊始就获得百万美元融资的案例,媒体和外界猜测Sakana AI的融资应该很快会有进展。

巧合在于,一位网友按耐不住留言表示,马斯克刚发帖说今天到日本了。

虽然他并未透露此行目的,还是引得不少网友猜测,难道马斯克又要出手了??

参考链接:

[1]https://www.theinformation.com/?rc=riq8lb

[2]https://www.reuters.com/technology/ai-chatbot-characterai-with-no-revenue-raises-150-mln-led-by-andreessen-horowitz-2023-03-23/

[3]https://arxiv.org/abs/2109.02869

[4]https://www.ft.com/content/1f0cee71-2a44-4080-8c79-b037243ac6f5

【本文由投资界合作伙伴36氪授权发布,本平台仅提供信息存储服务。】如有任何疑问,请联系(editor@zero2ipo.com.cn)投资界处理。

看了这篇文章的用户还看了

发展国产大模型,不能只堆算力

2023/08/21$tags$大模型,抖音快手终于来了!

2023/08/21$tags$大模型「上车」,车企打响「开城战」

2023/08/18$tags$从妙鸭爆火到老片修复,大模型已经开始干活了

2023/08/18$tags$MIT科技评论:讯飞星火被评为中国「最聪明」的大模型

2023/08/17$tags$大模型落地,痛并坚持着

2023/08/17$tags$

旗下微信矩阵:

旗下微信矩阵: