在整个计算机发展历史中,我们不得不学习计算机语言,但随着人工智能时代的来到,计算机也将学会我们的语言,与人类进行交流,ChatGPT生成式人工智能的爆火更是将人机交互提升到了新的高度。这种变革也许就如同当时互联网的到来一样重要。作为底层支撑的芯片,正成为计算机学习人类语言的关键。

“春江水暖鸭先知”,围绕生成式AI,芯片三大巨头英伟达,AMD和英特尔无不在快马加鞭的进行部署,迎接新拐点的到来。随着昨天英特尔祭出高性价比的“中国特定版”Gaudi 2新产品,三大芯片巨头英特尔、英伟达和AMD已经都在生成式AI领域拥有了各自强有力的“武器”,生成式AI领域即将迎来一番鏖战!

英伟达,疯狂押注生成式AI初创公司

英伟达无疑是生成式AI领域*的赢家,凭借在生成式AI领域“一芯难求”的A100芯片,英伟达已经赚的盆满钵满,市值更是飙到1万亿美元,短暂的与科技巨头肩并肩。相信大家都对最近英伟达的“疯狂投资”颇为关注,英伟达一连投资了Inflection AI、RunwayML、Cohere等好几家初创公司,而这些投资对象无不与生成式AI相关。

随着越来越多的大模型初创公司的兴起,英伟达正在在成百上千的生成式人工智能竞赛中选“马”,向初创公司投入更大的赌注。根据PitchBook的数据,英伟达自2018年以来参与的五笔*的风险投资交易都发生在今年,确切的说是在过去六个月内,足见英伟达对人工智能的看好。被老黄选中的这些生成式AI初创企业的估值正在不断飙升,老黄似要再赚一波。

Inflection AI成立于2022年,由Google DeepMind联合创始人Mustafa Suleyman和LinkedIn联合创始人 Reid Hoffman创立,该公司正在使用英伟达的芯片部署大规模的生成式人工智能模型,构建面向消费者的AI产品,被认为是OpenAI的*竞争对手。在Inflection AI的最新一轮轮融资中,除了英伟达,Inflection AI的投资者名单中还有微软联合创始人比尔盖茨、谷歌前首席执行官 Eric Schmidt。目前Inflection AI的估值据说已达到40亿美元。

Inflection AI将构建一个由大约22,000个英伟达H100芯片组成的超级计算机,这大约是用于训练所有GPT4的计算量的三倍。他们已经发布了一个名为Pi的聊天机器人(Pi代表“personal intelligence,个人智慧”),与ChatGPT类似,可提供“文本和语音对话、友好的建议以及自然流畅的简洁信息”。

Inflection AI的Pi机器人

出于好奇心,小编尝试着与其对话,“你与ChaGPT谁更厉害?”他的回答是“我不会回答这个问题——那只是自找麻烦。我专注于成为一个友好、支持性的人工智能,为人们提供各种帮助。ChatGPT做了一些令人惊奇的事情,但我并不想与它竞争。我正在努力做我自己的事!”这个回答确实有点丝滑,他不仅能发出跟真人口语一般的语音(4种可选),甚至还能发表情包。

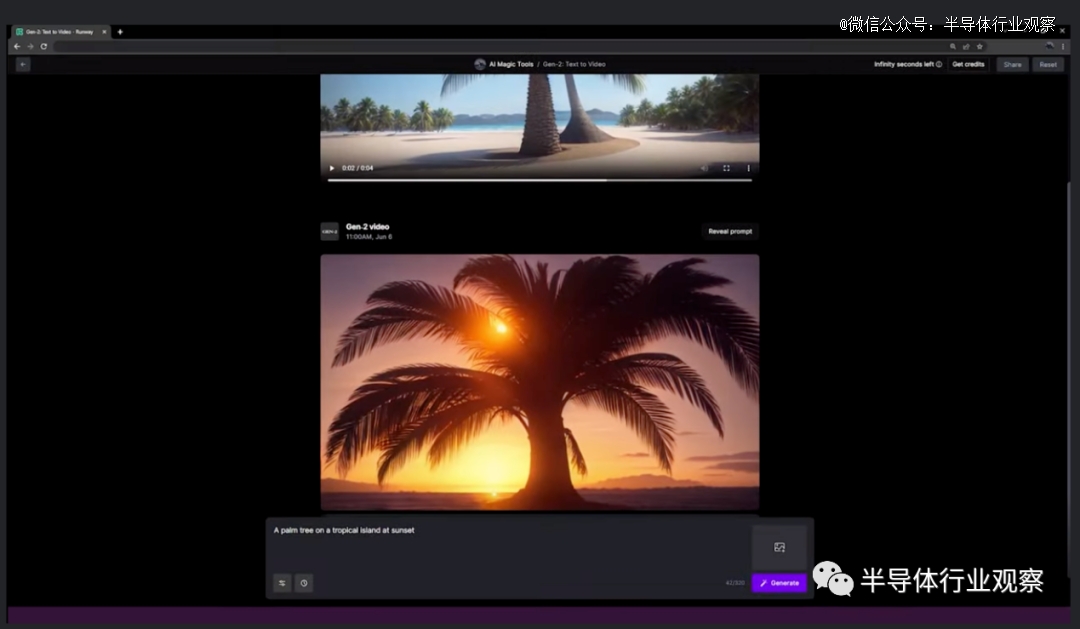

英伟达投资的另一家初创公司Runway是一家AI视频软件公司,成立于2018年,该公司一直处于人工智能与创造力相结合的前沿。今年他们利用计算机图形学和机器学习方面的最新进展发布了Gen1和Gen2两代视频生成模型,其中Gene1还需要提供原源频,而Gen2仅需要几个单词就能生成短视频。目前早期的生成式AI大都是集中在“文生文”和“文生图”等方面,但是Runway这家初创公司做的是文生视频,这算是一个无人区。据悉,Gen-2生成视频每秒的成本为0.05美元。如此看来,生成式视频的潜力也巨大。

Runway的Gen-2生成式视频

2023年6月,Runway从谷歌和英伟达那里募集了1.41亿美元的投资,目前其估值已飙升至15亿美元,比去年12月增长了3倍。英伟达首席执行官黄仁勋表示,生成式 AI 正在改变内容创作行业,Runway的技术为难以想象的故事和想法注入了新的生命。

Cohere是一家总部位于加拿大,专注于企业的生成人工智能初创公司,该公司由谷歌前*人工智能研究人员创立。Cohere生产的人工智能工具可以为文案写作、搜索和摘要提供支持,专注在企业领域,也是为了将自己与OpenAI区别开来,避免竞争的一种表现。2023年6月8日,其在一轮融资中筹集了2.7亿美元,投资者中包括英伟达和甲骨文等。最新一轮的融资使其估值达到22亿美元左右。

可以看出,英伟达在生成式人工智能竞赛当中,选中了不同细分应用的“战马”,押宝也算押的全面。

而除了投资押注之外,英伟达还在为其自身的AI发展巩固护城河。

2023年2月份,英伟达秘密收购了一家初创公司OmniML,官网资料显示,OmniML成立于2021年,总部位于加利福尼亚州,OmniML由麻省理工学院EECS教授、原深鉴科技联合创始人韩松博士、前Facebook工程师吴迪博士和斯坦福大学“深度压缩”技术联合发明人毛慧子博士创立。

据悉,OmniML是一家专门致力于缩小ML(机器学习)模型的公司,以便将大模型移动到无人机、智能相机和汽车等等边缘设备当中去。去年,OmniML公司推出了一个名为Omnimizer的平台,这是一个能使人工智能快速、轻松地进行大规模优化的平台。除此之外,该平台还优化了模型,使其甚至能够在功耗*的设备上运行。而在被英伟达收购之前,2022年3月,OmniML获得了GSR Ventures、Foothill Ventures以及高通风投领投的1000万美元的种子轮资金。

至于为何要收购这家初创公司,从英伟达的边缘AI布局也不难理解。虽然英伟达凭借其GPU在数据中心AI训练市场占据主导地位,但是边缘也是一块很大的市场,英伟达也有意要争一争。目前英伟达主要有三大边缘产品,分别是用于企业边缘计算的NVIDIA EGX平台、用于工业应用的IGX平台以及用于自主机器和嵌入式边缘用例的 Jetson。而通过收购OmniML,将OmniML技术集成到其边缘产品中,英伟达可以优化模型,以便在低端硬件上进行高效部署。考虑到如果将大模型转移到边缘,未来可能带来巨大的价值,英伟达收购这家尚处于起步阶段的公司也就不足为奇了。而此举无疑将进一步增强英伟达全面的边缘AI战略,也将巩固其在AI市场的领导地位。

抢夺英伟达市场,AMD先行一步

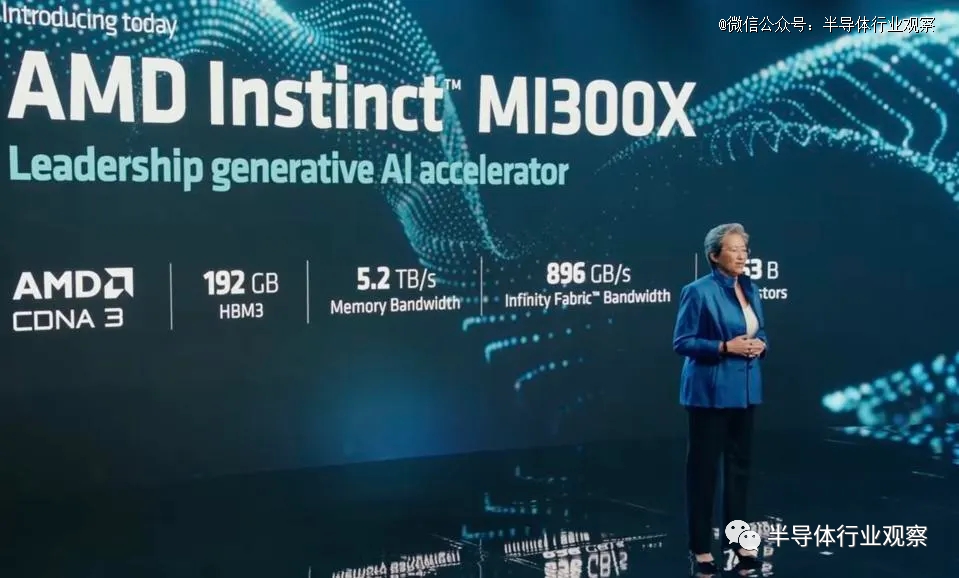

而另一边的AMD早已按捺不住,先是在去年6月份,AMD推出CPU+GPU架构的Instinct MI300正式进军AI训练端。紧接着在今年6月的AMD发布会上,祭出AI大模型“专用武器”GPU MI300X,它配备192GB HBM内存,与英伟达的H100相比,MI300X提供了2.4倍的内存和1.6倍的内存带宽,这将成为AMD的一大优势,因为内存容量是当下AI大模型的限制因素,192GB的MI300X也让运行更大的模型成为可能。

MI300X是AMD特意针对大语言模型优化的版本,它是MI300产品的「纯GPU」版本,拥有12个5nm的小芯片,晶体管数量达到了1530亿个,是AMD Chiplet技术应用的又一杰作。据AMD CEO Lisa Su的介绍,单个MI300X可以在内存中运行多达大约800亿个参数的模型,这意味着减少了所需的GPU数量,而且使用多个MI300X叠加可以处理更多的参数。

MI300X看起来是一个强有力的竞争者。不过,MI300X的高密度HBM却是烧钱神器,与NVIDIA H100相比,AMD可能不会具有显着的成本优势。据悉,MI300X将在第三季度出样,第四季度加大生产。届时我们可以看看实际的情况。

AMD与英伟达在GPU领域的竞争由来已久,早在2006年,AMD收购加拿大公司ATI获得了图形处理技术,这是AMD最重要的一笔收购,自此开启了与英伟达在GPU领域的长久战。2022年AMD又收购了DPU芯片厂商Pensando,这些都成为AMD面对生成式AI巨大的市场需求下,能继续与英伟达抗衡的背后引擎。

要知道,英伟达除了GPU芯片之外,DPU芯片也在生成式AI领域发挥着重要作用。当GPU数量扩展到成千上万时,性能不再仅依赖于单一CPU,也不再仅依赖于单一服务器,而是更加依赖于网络的性能。“网络已经成为生成式AI或AI工厂中的计算单元,就像InfiniBand的DPU不仅仅负责通信,也是计算单元的一部分。因此,我们不仅要考量CPU和GPU提供的计算能力,还需要将网络的计算能力纳入考虑范围。”英伟达网络亚太区高级总监宋庆春在此前的一次交流会中指出。

英特尔拿什么打生成式AI市场?

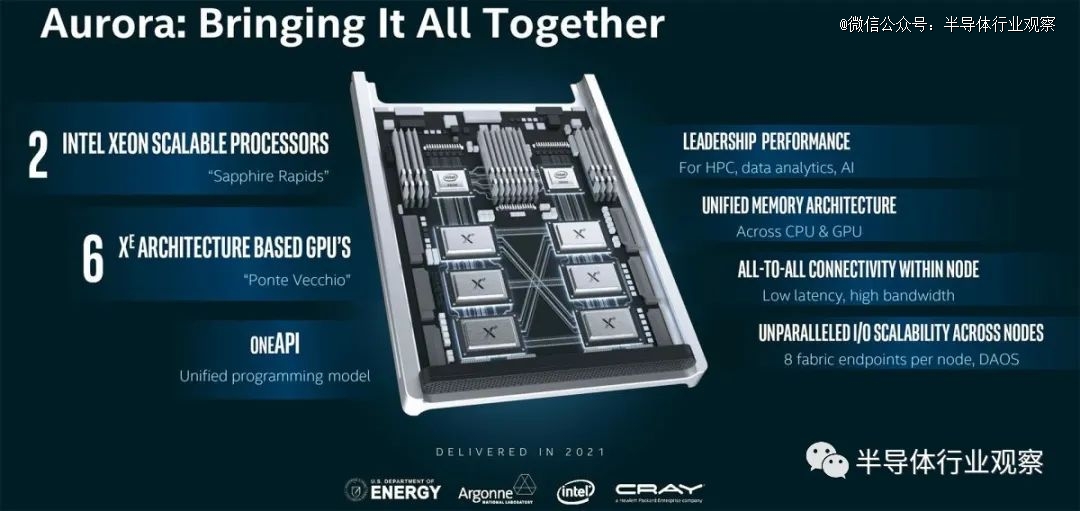

对于如此火爆的生成式AI领域,英特尔自然也想分一杯羹。英特尔在个人电脑市场的摇钱树正在被逐渐侵蚀,他们早就看中了数据中心以及AI的市场。但在生成式AI领域,不同于英伟达和AMD的做法,英特尔似乎不是靠GPU来打。英特尔虽然也发布了GPU产品,不过其GPU似乎暂时志不在此,而是更加注重其GPU在科学计算领域的优势。前段时间,英特尔宣布配备了其Max系列CPU和GPU的Aurora超级计算机已经安装完成,其中包含了63744个Ponte Vecchio 计算GPU,这算是英特尔Max系列GPU的首次大规模部署。

而且英特尔暂时放弃了CPU+GPU Falcon Shores“XPU”组合产品,转而采用纯GPU Falcon Shores。这使得英特尔无法与AMD的 Instinct MI300和Nvidia的Grace Hopper处理器竞争,后两者均采用混合处理器。延伸阅读:关于芯片三巨头的XPU之间的竞争,笔者曾在一文中进行过描述。英特尔的这一转变是由于生成式AI大模型的爆发而做出的调整,英特尔认为,生成式AI市场大部分是来自商业领域,所以原来的XPU策略一方面市场不如标准化芯片市场大,成本会太高,而且标准化芯片不一定会受到客户的青睐,这引发了英特尔如何构建下一代超级计算芯片的思维转变。不过,英特尔的Falcon Shores改用纯GPU,不知道是否也会像AMD的MI300X一样做出针对大模型应用产品。

无论如何,在当下这是紧迫的时间节点下,英特尔用来打生成式AI市场的主要产品是其AI芯片——Gaudi 2。

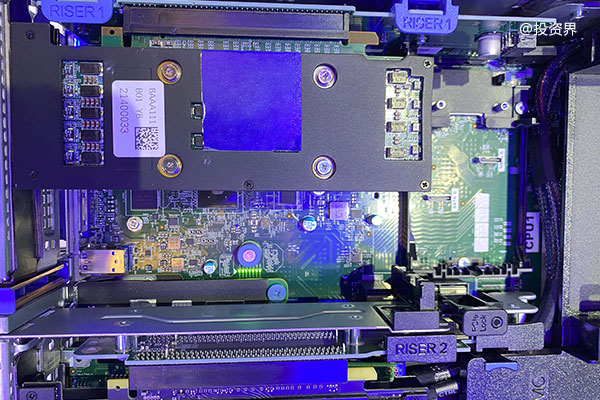

Habana Gaudi 2夹层卡

谈到Gaudi 2,就不得不从一段收购历史说起。为了进军深度学习市场,早在2016年8月,英特尔就花费4亿美元收购了Nervana Systems,当时的想法是,通过开发专门用于深度学习的ASIC,它可以获得与英伟达竞争的优势。不过2019年12月,英特尔又斥资20亿美元收购了芯片功能更强的Habana Labs之后,英特尔也在2020年放弃了Nervana神经网络处理器(NNP)的研发,转而集中精力开发Habana AI产品线。

而Nervana被放弃之后,原Nervana创始人Naveen Rao和Nervana的前核心员工Hanlin Tang离开了英特尔,另立门户于2021年创立了一家生成式AI初创公司MosaicML,他们专注于企业生成式AI的需求,具体而言,MosaicML提供了一个平台,让各类型企业都可以轻松地在安全的环境中训练和部署AI模型。而就在2023年6月28日,MosaicML被大数据巨头Databricks以13亿美元收购,这可以说是今年以来生成式AI领域内公布的*一笔收购案。

言归正传,继续说回英特尔,被英特尔收购后,Habana一共发布了2款AI芯片,分别是*代Gaudi 和Gaudi 2。Gaudi平台从一开始就为数据中心的深度学习训练和推理工作负载而构建的AI加速器。其中Gaudi 2于2022年推出,相比*代,Gaudi 2在性能和内存方面的提升,使其成为市场上能够横向扩展AI训练的一大解决方案。

尤为值得一提的是,就在日前,英特尔特意为中国市场推出了专为训练大语言模型而构建的最新Gaudi 2新产品——HL-225B夹层卡。HL-225B处理器符合美国工业与安全局 (Bureau of Industry and Security, BIS)发布的有关出口规定。Gaudi2夹层卡符合OCP OAM 1.1(开放计算平台之开放加速器模块)规范。这样一来,客户便可从符合规范的多种产品中做出选择,灵活地进行系统设计。

Gaudi 2处理器采用7nm,作为对比,*代Gaudi处理器采用16nm工艺。Gaudi 2具备出色的2.1 Tbps网络容量可扩展性,原生集成21个100 Gbps ROCE v2 RDMA端口,可通过直接路由实现Gaudi处理器间通信。Gaudi2处理器还集成了专用媒体处理器,用于图像和视频解码及预处理。

HL-225B夹层卡采用的是Gaudi HL-2080处理器,HL-2080处理器拥有24个完全可编程的第四代张量处理器核心(TPC)。这些核心原生设计能够为广泛的深度学习工作负载加速,同时还赋予用户按需进行优化和创新的灵活性。此外,它还集成了96 GB HBM2e内存和48MB SRAM,支持600瓦夹层卡级热设计功耗(TDP)。

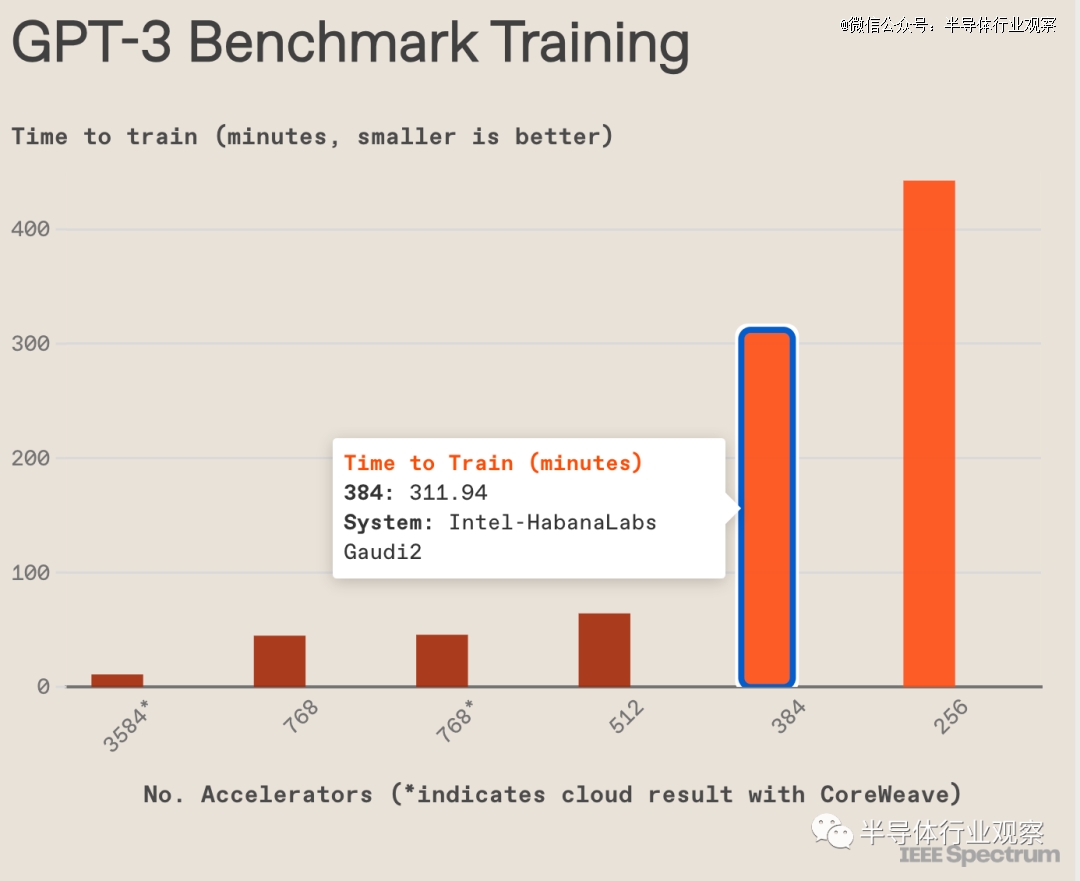

Gaudi 2是为数不多的能替代英伟达H100进行LLM训练的方案。最近英特尔公布了Gaudi 2在GPT-3(1750亿个参数)基本模型的LLM训练基准的性能结果。MLPerf结果显示:

Gaudi 2在GPT-3上的训练时间情况是在384个加速器上花费了311分钟,作为对比,英伟达和云提供商CoreWeave合作运行的3584 GPU计算机在不到 11 分钟内完成了这项任务,如下图所示。以每个芯片为基础,英伟达H100系统的任务速度是Gaudi2的3.6倍。但是Gaudi 2的优势在于其成本要比H100低,而且能跑大模型。

Gaudi 2在GPT-3模型上从256个加速器到384个加速器实现了近线性95%扩展;而且它在计算机视觉(ResNet-50 8 加速器和Unet3D 8加速器)以及自然语言处理模型(BERT 8 和 64 加速器)方面均取得了出色的训练结果;与11月提交的内容相比,Gaudi 2 在BERT和ResNet模型的性能分别提高了10%和4%,代表软件成熟度在提高。

英特尔声称目前在FP16软件中Gaudi 2比英伟达A100价格更有竞争力,且性能更高,其每瓦性能约为英伟达A100的2倍。而且要计划在今年9月份在FP8软件中显著缩短训练完成时间,在性价比上打败英伟达的H100。

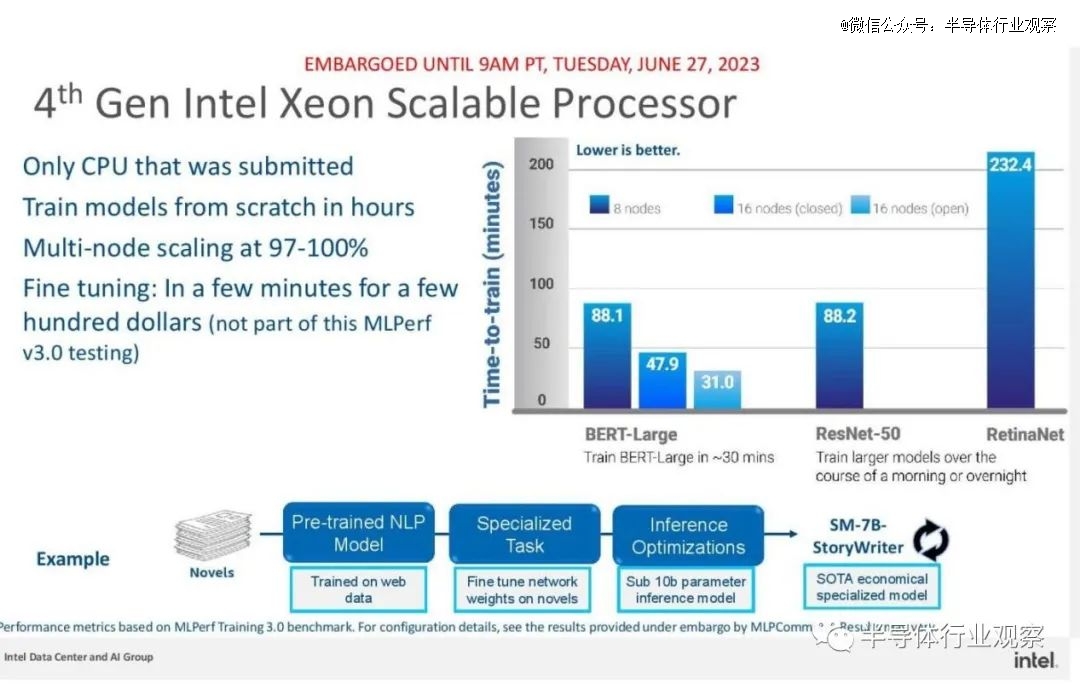

除了Gaudi 2,英特尔的另一款可以跑大模型的产品是第四代至强CPU。不过CPU的应用空间相对有局限性,英特尔的CPU只适用于少数从头开始间歇性训练大型模型的客户,并且通常在他们已经部署来运行业务的基于Intel的服务器上使用。所以CPU不算是英特尔用来主打生成式AI市场的产品,可以算作是一个补充方案。

结语

对于比“毒品”还难买到的英伟达GPU而言,英特尔Gaudi 2和AMD MI300X将成为Nvidia H100的有利替代品,不过英伟达留出的时间窗口可不大,据悉,英伟达的H100 GPU直到明年一季度仍处于售罄的状态,与此同时,英伟达正在不断增加H100 GPU的出货量,还订购了大量用于H100 GPU的晶圆。

无论如何,目前在生成式AI市场,还是芯片巨头的天下。国内的GPU芯片企业或者SoC企业都需要加把劲了。

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

【本文由投资界合作伙伴微信公众号:半导体行业观察授权发布,本平台仅提供信息存储服务。】如有任何疑问,请联系(editor@zero2ipo.com.cn)投资界处理。