如何预测未来?知名未来学家KK曾说,其预测未来的框架模型是回到当下,关注正在发生却还没有被主流所关注的东西,因为创新很多时候都是从边缘开始。

然而边缘有时也意味着在很长一段时间孤独前行。

人工智能的无人知晓时刻

如今人们确信的深度学习,在30年前仍然是一个前途未卜、被同行学术圈边缘化的研究。

20世纪80年代,朱迪亚·珀尔提出了贝叶斯网络的概念,将潜在原因与一组可观察的条件通过贝叶斯网络的方式联系起来,这种反事实算法用来在不实际实施干预的情况下预测干预的效果。但是由于主流学术仍然推崇以逻辑为主的数学定理,对于这种并非基于严谨数据的因果关系嗤之以鼻。

直到2011年,也就是深度学习开始逐渐普及,朱迪亚·珀尔的反算法才获得更广泛的认可,并获得了当年的计算机届的“诺贝尔奖”图灵奖,中间过去了近30年。

而如今的深度学习巨头Geoffrey Hinton在当时注意到了反事实算法,并在1986年在《自然》杂志上发表的《Learning representations by back-propagating errors》论文中证明反向传播算法可以帮助神经网络发现数据的内部表示,解决过去无法解决的问题。当时其就提出一个想法:我们将拥有一个由单词组成的句子,并预测最后一个单词。

这是*个语言模型,和如今OpenAI、Bard所做的事情非常像,但是从1986年提出到OpenAI的GPT 1大模型出来,过去了近32年,这也是Hinton的大半个学术生涯。

实际上用神经算法做的预测比当时主流的符号AI效果更好,但是这个结果却被人忽视了,因为这仅仅是基于108个句子组成的数据集,这么小的数据集不足以让人相信其可靠性。此时Hinton学术直觉告诉他,如果数据更大,算力更强大,或许可能更能凸显神经网络的优势,但这只是推测。摩尔定律带来了PC端的繁荣,大幅降低了计算机成本,在Hinton发布反向传播算法的前一年,英特尔推出了*代32位处理器,并可进行多任务处理,每秒可以处理500万条指令,但是对于神经网络来说远远不够。

更为重要的是,当时主流的人工智能学术路线主要以数学理论为基础的AI符号主义,而Hinton所坚持的神经网络路线因为没有逻辑和推理理论,只是基于神经元之间的连接变化,一直被主流学者边缘化。在当时的小数据集时期,两者效果相当。

当时Hinton学生Yann Lecun的日子也不好过。Lecun在当时提出了“卷积神经网络(LetNET),这成为后来深度学习的一个基本原理,但是在那时却被同行嗤之以鼻,认为是“过时的理论”。

那时正是人工智能寒冬时期,符号学路线正着手研究的专家系统曾被认为能解决垂直领域的商业问题并获得产业方资助,但后来由于其所需专业的昂贵计算机被通用计算机所取代,AI研究再次受阻。

雪上加霜的是,Lecun坚持的路线还被同行排斥,甚至不让其参加主流的人工智能大会CPVR。有趣的是,2012年Lecun和Bengio牵头组织了ICLR大会,旨在促进深度学习同行的交流。可见Lecun对神经网络的研究和探索从未动摇过。

在其所在的贝尔实验室项目组因内部斗争被动解散后,Lecun去往纽约大学担任教授,并和Hinton以及他的同门Bengio以分布式协作方式继续推进神经网络的研究。

Yoshua Bengio是Lecun的同学,也是其贝尔实验室的同事。在2000年,Bengio发表了《A Neural Probabilistic Language Model》,这篇论文首次提到注意力机制,虽然当时只将其应用于机器翻译上,但也为后来Transformer架构打下了基础,可惜的是由于太过前沿,当时并没有人认识到这点,直到17年后。

深度学习转折期

之后的6年,人工智能方面的研究一直在继续,但却一直不温不火,没人意识到,2006年是深度学习最为关键的转折年。

2006年,Hinton仍在多伦多大学任教,并和他的学生发表了一篇名为《Unsupervised Learning of Image Transformations》的文章,提出通过预训练的方式来实现机器的无监督学习,这是如今生成式AI预训练学习的雏形。在此之前,机器学习更多是基于有监督学习的方式,通过打标签将现实世界物体和虚拟数字世界一一对应,主要做的事情为判断你面前的物体是否与图片、声音一致。

那时英伟达CEO黄仁勋还不认识Hinton的学生Ilya Sutskever(如今的ChatGPT首席科学家)。2006年,已经成立了13年的英伟达在GPU领域开始站稳脚跟,并考虑更大的发展,软硬一体开始成为了英伟达的战略重心。在那一年,英伟达推出了CUDA,可以帮助程序员编程和访问GPU实现的计算能力和*并行性,在此之前让程序员对GPU进行编程是极其低效的。

CUDA能大大降低程序员的开发门槛,但是当时客户愿意买单的屈指可数,因为前期成本涨了不止一倍,英伟达只能自己扛下上升的这部分成本,导致利润大幅下滑。不过,黄教主没有动摇,终于在投入研发3、4年后,也就是2006年将CUDA推向了市场。

在此后的一年,担任斯坦福大学人工智能实验室主任的李飞飞启动了一个名为“ImageNet"的项目,项目的主要工作是收集高质量图片并打标签,因为在李飞飞看来,除了算力之外,数据集规模的扩大也是提升算法的一种方式,需要更高质量更大规模的数据集。这与当时以前沿理论研究为主的同行格格不入,甚至被同行嘲笑这项研究不值一提。由于研究的边缘化,其在申请项目经费上也屡屡破壁。

但是李飞飞并不在意。在尝试了实习生收集图片和算法收集效果效率都不太满意后,李飞飞无意中得知了Mechanical Turk,通过这种便宜的全球人力分包方式,ImageNet收集了1300万张图片。

2009年李飞飞和其团队发表了ImageNet的相关论文,并联合当时的CVPR会议,推出了之后视觉识别领域知名的ImageNet挑战赛。参赛者对视觉图像的准确识别率成为了是否获胜的关键。

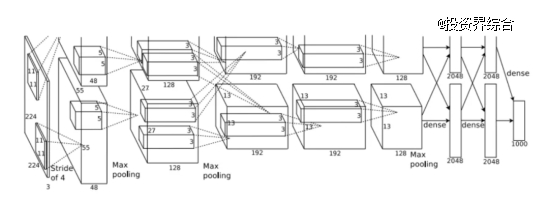

图:AlexNet算法基本原理

2012年,ImageNet迎来了三位神秘的挑战者,人工智能初期的齿轮开始转动。这三位挑战者就是Hinton以及他的学生Alex Krizhevsky、Ilya Sutskever。

当时Ilya Sutskever和黄仁勋刚认识不久,Alex Krizhevsky则是GPU高性能编程的高手,这为AlexNet使用GPU打下了基础。有一天,Hinton在多伦多大学实验室提议Ilya Sutskever,要不我们试试在GPU上跑神经网络吧。于是他们找来了只有3G内存的GTX 580 GPU,并将神经元分为两半,分别在2个GPU上训练。这与如今动辄40GB内存的GPU相比简直小巫见大巫。

当时团队从研究中得到了启示,意识到原来神经网络是可以被训练的,如果这样的话,那不妨训练一个大模型。据Ilya回忆,正当他们要寻找一个大数据集时,ImageNet出现在眼前。

历史总是惊人的巧合,GPU、大数据集、AlexNet算法三条平行线终于在此刻交汇,并带来了深度学习的爆发。

他们参加了当年的ImageNet比赛,其视觉识别错误率首次低于25%,打破了记录,震惊全场,并由此重塑了整个计算机视觉领域,之后他们将这个算法命名为“AlexNet",这也是首次将GPU用于深度学习中。

基于AlexNet卷积神经网络,深度学习领域的*波AI应用浪潮开始,更多AI应用公司开始基于AlexNet和GPU进行训练,像国内的AI四小龙也是在这个阶段诞生的,之后挑战者在此基础上不断刷分。

值得一提的是,AlexNet并没有在当年获得奖项,直到10年后才由于其对深度学习的深远影响,获得NeurIPS时间检验奖。

作为一名生态构建者,李飞飞在那一刻终于向世人证明她的判断是正确的。受到ImageNet的启发,之后谷歌、Deepmind、微软等公司也开始陆续推出自己的数据集。

在AlexNet无形中帮GPU带货后,黄教主看到了GPU在深度学习领域发展的潜力,在移动手机市场竞争败下阵来后,转而决定在人工智能领域发力,并在之后推出AI加速器、Hopper架构等产品,这就是AI 1.0时期。

值得一提的是,2010年Bengio提出的生成对抗网络(GANs)可以自动生成图像,也助力了图像和视觉的革命。

Hinton和其学生也通过这一战获得了更多同行的认可,也是在此时神经网络从边缘走向人工智能的舞台中央,一些学者也开始转向神经网络。

此后Hinton和Alex Krizhevsky、Ilya Sutskever成立了公司DNNResearch,除了三位人才,公司其实和空壳无异,但却引来了四家互联网巨头的竞相拍卖,最终谷歌以高价胜出,2013年他们加入谷歌,成为谷歌大脑员工。

生成式人工智能爆发前夕

所有技术发展都遵从J型曲线。AI 1.0时期主要基于小模型,解决问题的能力有限,更做不到理解人的程度,AI 1.0在发展了一段时间后又陷入到增长停滞,直到2017年。

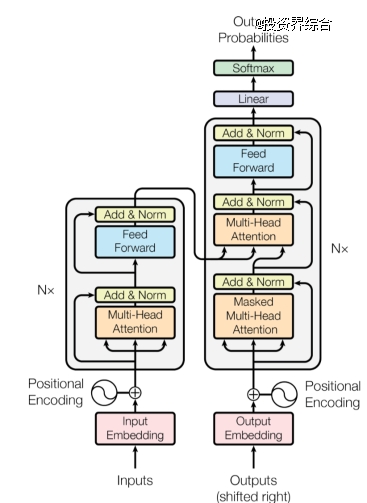

2017年一个普通的工作日下午,当Ashish Vaswani和Jakob Uszkoreit在谷歌办公室走廊探讨如何改进谷歌翻译,此前他们与Illia Polosukhin提出了自注意力概念。不同于过往按照序列逐字翻译,自注意力是一次性阅读整个句子,分析其所有部分而不仅仅是个别单词。

图:Transformer架构

这个改进翻译的项目被另一名正在为语言生成方法感到沮丧的程序员Noam Shazeer听到,并自愿加入到这项研究中。这个临时组成的松散项目组经过几个月研究,提出了一种处理语言的架构,也就是生成式AI爆发的关键因素——Transformer。团队将研究成果整理成了论文,并命名为《Attention is All You Need》,据说是借鉴了披头士的一首歌。可能这八名谷歌员工也没有想到,为提高谷歌翻译而做的研究最终开启了生成式AI的新时代。

这篇论文申请了机器学习领域最知名的会议NeurIPS,虽然被现场研究人员包围的水泄不通,但在当年这篇论文并没有获得任何奖项。

很多时候,新的技术研究出来时可能很多人并没有认识到它所能带来的影响力,即使是当时行业中最*、专业的研究人员。

但有一个人很快注意到了Transformer即将掀起的AI行业变革,他就是前文提到的Ilya Sutskever。

2015年,Sam Altman和Greg Brockman作为做局者,在Bengio推荐的*AI科学家名单中邀请了10名研究员,在硅谷附近的Napa酒庄聚会,倡议一起干一件大事,利用人工智能造福全人类,以负责任的方式推进人工智能,这完全是对着谷歌打。在此前一年,谷歌刚以6亿美元价格收购了人工智能研究机构Deepmind,Sam Altman和Greg Brockman马上认识到,AI不能被大企业所掌控。OpenAI这个乌托邦的梦想和非盈利机构的性质让Ilya Sutskever拒绝了谷歌开出的2倍薪酬,毅然决然地加入了这家创业公司,并担任OpenAI的首席科学家。

在过去的20多年里,Ilya Sutskever的学术生涯和AI研究紧密挂钩,他也取得了一些不错的成绩。或许是某一天突然间的自我觉醒,或许是受之前谷歌同事对于AGI追求的影响,Ilya Sutskever开始将AGI作为追求目标,而如果要实现这一目标,那么一定要做大模型。

在谷歌Deepmind团队推出的AlphaGo打败了围棋冠军李世石后不久,Ilya Sutskever和他的团队也突然“开小差”,训练神经网络玩Dot 2,并与*秀的玩家PK。这次看似无用的开小差给了OpenAI团队灵感,埋下了运用人类强化反馈学习的种子。

当时正打算训练GPT 1模型时,Ilya Sutskever注意到了刚发布不久的Transformer,心里窃喜,"太棒了,就是它了。"

2018年,GPT1推出,它基于Transfomer架构,通过无监督预训练的方式,帮助生成下一个词。第二年,基于更大数据集的大模型GPT2推出,回答更加流利,且回答问题类型更广。第三年,GPT3使用了1750亿参数进行训练,比GPT2使用的参数扩大了近116倍,也产生了更加令人震惊的效果——涌现,大模型理解力飙升。

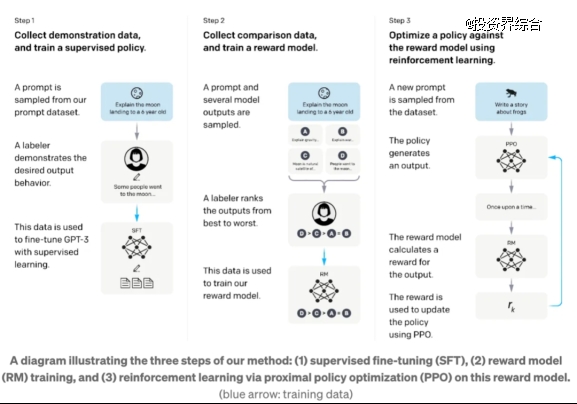

没人注意到的是,在发布基于GPT3.5的ChatGPT之前的2022年1月,OpenAI团队曾推出过一个GPT-3.5微调版本InstructGPT,当时采用的是人类反馈的强化学习(RLHF),研究员发现当发出任何语言指令时,它更容易理解人了。不过由于当时并不是TOC版本,外界并没有注意到该机制将为深度学习带来怎样的效果提升。

图:InstructGPT实行人类反馈强化学习步骤

10个月后,基于GPT3.5的ChatGPT推出,不到5天注册用户就突破了百万,超过PC互联网和移动互联网任何产品的获客速度,这也超出了OpenAI团队的预料。此时回溯成功背后的原因时,人们才真正注意到7个月前那篇挂在arxiv网站上的论文《Training language models to follow instructions with human feedback》。

ChatGPT的火爆让AI 2.0真正进入到了更多人的视野。也是那一年,图灵奖罕见地颁给了三个人,Hinton、Lecun、Bengio,致敬他们为探索深度学习突破所做出的努力。这离他们开始从事神经网络研究过去了近30年,Hinton已满头银发,Lecun依然笑容可掬,但脸上留下了光阴雕刻的痕迹。

Hinton、Ilya Sutskever以及更多的AI科学家或许会感到欣慰,从事AI研究几十载,终于看到了神经网络向AGI迈出了重要一步。过去行业的冷嘲热讽、被边缘化、生活窘迫等种种不如意,都在这一刻全都烟消云散了。

AI2.0生态初现

如果用反向传播算法追溯AI发展历史,会发现在反复输入Token,人类反馈强化学习后,输出了惊人的效果,只不过这个名为“AI创世纪”的大模型的输入横跨了超过66年,由世界各地*AI科学家写就。

如果没有Hinton、Lecun、Bengio三位深度学习巨头对神经网络的几十年如一日的坚持,或许我们将走向另一条道路,仍徘徊在小模型的门口;如果不是李飞飞的执着,或许还没有人意识到数据集的重要性;如果不是Alex Krizhevsky、Ilya Sutskeve的努力,或许我们视觉识别能力仍没法突破;如果没有黄教主的战略眼光,或许GPU在AI的应用还得晚几年;如果没有Bengio提出的注意力机制,或许Transfomer机制能否诞生并不确定;如果没有后来谷歌研究员的“走廊谈话”,或许也就没有ChatGPT的出现,生成式AI或许还未拉开序幕。

此外商业化运作以及与合作伙伴的合纵连横也成为了点燃这一波生成式AI的催化剂。如果没有谷歌在2014年收购Deepmind,或许OpenAI也不会出现;如果没有OpenAI从非盈利组织变成盈利组织,并抱上微软大腿,为其提供算力和资金支持,或许ChatGPT推出还得晚几年。谷歌和OpenAI的竞争,微软和谷歌的巨头碰撞,间接促进AI研究的加速,并推进了其商业化进程。

技术发展总是螺旋式上升。在当下的视野,技术进步始终在缓慢前进,那些在过去边缘化的创新经过一段时间的积淀才逐渐站在舞台中央,幸运的是前人没有停止探索,在前途未明的探索期,在人工智能寒冬期,他们始终坚持对创新的追求,才有了AI创世纪的到来。

在计算机的几个*奖项中,会设置一个特别奖项——时间检验奖,以表彰至少在十年中对行业带来重大影响的论文。这或许是对坚持创新的人最高荣誉,也是对当下没有被认识到其创新影响力的查漏补缺。改变未来的前沿技术终会通过时间的炼狱,证明其价值。

比如2011年一篇推荐系统的文章在10年后获得了2021年KDD时间检验奖,而此时推荐系统已经被广泛应用在纽约时报内部。如今在各类社交网站的推荐系统的创新都来源于对前沿技术的探索。

当然AI 2.0的故事还只是开场,AI人才的流动也如吹散的蒲公英般构建了AI 2.0的创业生态。

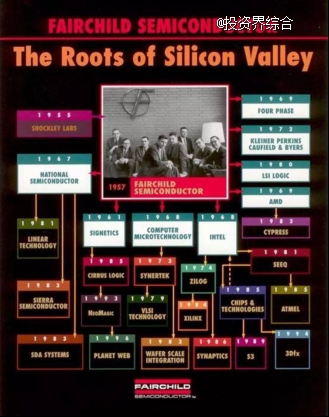

图:Transformer论文八子纷纷出走谷歌,创立或加入AI公司

当年Transformer论文八子纷纷离开谷歌,多数投身到了AI创业公司中。Noam Shazeer创立了Character.ai,估值超10亿美元,AidanGomez离开后创立了生成式AI公司Cohere,JakobUszkoreit创立用深度学习技术设计“生物软件”的公司Inceptive,Illia Polosukhin投身AI+编程(后转向区块链领域),Vaswani和Parmar离开后创立了关注商业领域应用的AI公司Essential.ai,Llion Jones在日本创立AI公司sakana.ai,Lukasz Kaiser加入OpenAI公司。

图:以仙童半导体公司“八叛将”为发端,影响了后来整个互联网生态圈

该景象不由让人想起半导体产业开端之时,肖克利实验室“八叛将”出走,共同成立了仙童半导体公司,并获得历史上*笔风险投资,之后他们又陆续出来,创立了AMD、英特尔等后来改变世界的公司,部分人投身KPCB、红杉资本等投资机构,继续支持互联网和移动互联网的新星们。截止至2014年,硅谷有7%的科技上市公司可以追溯到与仙童半导体的关联。

而现在AI生态也正在逐步建立,他们可能很多人来源于Hinton的多伦多实验室或者谷歌Deepmind亦或者是国内的智源研究所、大学研究院,之后他们流向了产业公司或者创立了自己的AI企业,又培养了新一拨的AI人才,促进了整个AI生态的繁荣。

他们将AI技术包装成产品、平台、解决方案,并赋能更多行业,而背后资本成为他们改变世界的重要力量,正如风险投资诞生时的初衷,帮助创业者将想法转化为产品和市场。创业者们不再需要坐冷板凳了。

作为聚焦于AI早期和成长期的投资机构,锦秋基金追溯创新的源头,洞察这些正在发生的边缘创新,捕捉*创新和产业头脑的创业者,并与他们站在一起,加速创新的发生,并共同携手改变世界。

如果你关注AI领域,同时愿意与我们一起构建创新生态,善于发现在各个角落、大学、研究院、大公司、创业公司中将在未来作出伟大变革的创业者,那么欢迎加入锦秋大家庭,成为我们投资团队的一员。

招聘岗位:AI领域投资经理/分析师

招聘要求:

我们希望你不唯经验论,因为在锦秋基金的文化中,我们更看重Openminded和较强的学习能力,将自己作为不断升级迭代的系统,是发现未来伟大企业的关键因素。

我们希望你热爱AI领域,了解相关产品技术,是各类AI产品的*体验官,对AI产品有独特见解,因为在锦秋基金,自下而上的产品用户体验和自上而下的行业mapping是一名优秀投资人的必备素质。

我们希望你具备较强的Social能力,善于建立自己的创业者生态网络,能和AI创业者、学者打成一片,因为在锦秋基金看来,产业投资时代,建立生态和投资策略同等重要,到创业者中去!

如果你满足上述条件,欢迎投递简历给我们~

投递邮箱:hr@jinqiucapital.com

Now contacting us is AllYouNeed,

then AllYouNeedis connecting startups !

参考资料:

1.《风险投资史》,Sebastian Mallaby

2.《万字揭秘OpenAI成长史:一度被谷歌“吊打”,还和马斯克搞“决裂”》,硅谷101

3.《Full interview: "Godfather of artificial intelligence" talks impact and potentialof AI》,CBS morning

4.《Fireside Chat with Ilya Sutskever and Jensen Huang: AI Today and Vision of the Future》,英伟达官网

5.《The Mastermind Behind GPT-4 and the Future of AI》,Eye On AI